考研_数学一_概率论

2023/3/2 10:01 大三下学期的专业课对概率论的要求越来越高了,所以这段时间决定概率论开始看视频复习;

2023/3/6 16:41 个人感觉概率论不需要再像高数一样完整的把视频看完(本身也有基础,况且宋浩的课程并不是严格按照考研大纲来的),直接跟着教材原有的笔记和拓展的笔记过一遍即可,或者可以直接上手张宇的概率论30讲;

2023/3/6 21:20 现在尝试直接上手余丙森的概率论与数理统计的讲义,视频什么的暂时不用看了;

2023/3/6 23:14 余丙森的教材用来速刷还是很不错的,只是感觉知识点的讲解不是很详细,可能因为是考研书籍吧,更多的还是注重于刷题过程中掌握知识点;

2023/3/12 19:27 本来想尝试把余丙森的教材换成张宇的(本以为张宇的教材讲的更细致一点,知识点的过渡也比较自然),但是使用之后发现概率论这门课确实越精简越好,所以还是换回余丙森的教材;现阶段不想刷题就不刷题吧,按照自己喜欢的复习方式来就OK,简单过一遍知识点也没问题;

2023/3/27 21:46 本来想的是直接硬啃书,但是发现到后面需要理解概念的时候硬啃书难度较大,还是需要看视频;

2023/3/28 20:08 张宇的概率论视频可以跟,边听边做笔记,听完之后对每一小节做总结,可以把余丙森的教材作为预习,张宇视频作为理解,最后的总结作为吸收,分三个阶段学习概率论;

2023/3/30 10:34 概率论和线代没必要把书上的知识点总结的仔仔细细,只需要按照之前期末复习的笔记和视频课的重点总结关键的信息即可(高数是因为必须把基础知识掌握牢固),张宇的课和教材都很好,所以直接放弃余丙森的书,看完张宇教材之后结合重点整理到blog即可;

2023/4/20 23:38 现在需要做的就是停下来,把第二章和第三章的例题开始刷起来巩固知识点,同时高数也应当继续复习;

2023/5/15 12:25 第四讲的习题未全部完成,第五讲和第六讲仅总结了教材知识点并未刷题(不要过于纠结某些知识点的理解,会做题就行,会做题之后再理解会轻松的多);

2023/5/15 17:34 书本知识点总结完毕,将高数和线代知识点总结完毕后进行刷题巩固;

2023/6/18 19:46 不要忘了概率论之前整理的笔记,对于一些很难搞清楚的概念之类的可以参考笔记(毕竟笔记也是当时耗费大量时间整理的);

2023/7/18 15:41 今天复习第五讲的时候再次用到了之前整理的笔记,概率论当时整理的笔记真的是很好的,一定要整理下来!!! 现在(16:59)已经基本把之前大二学习概率论时候的笔记整理完毕,只剩下最后区间估计的知识点因为涉及做题过程中理解,所以暂时先不整理,之后有需要可以回过头看看。现在基本上没什么疑惑点了,其实只要搞清楚概率论和数理统计两门学科之间的关系就能很容易的搞清楚这六章知识点的脉络。相对来说第五讲作为过渡性知识点会比较简单,而第六讲作为最终集大成者,基本上是考研题的大题所在,需要花时间理解和刷题掌握;

2023/9/1 概率论强化开启

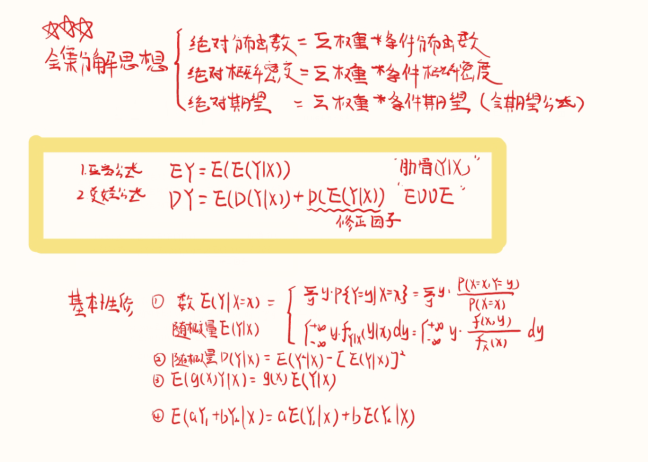

2023/9/2 10:58 全集分解思想后面应该还会深化,此处暂时不整理(张宇的概率论强化前后关系比较密切,最后学完九讲后建议从头到尾检查一遍有没有没复习整理到的)

2023/9/4 17:31 不管效果怎么样,总之在前前后后各种心态爆炸以及焦虑的情况下,完成了最终对概率论的强化,基本上所有的知识点都整合完毕(不要过于在意是否遗漏什么知识点,不可能把考题所有的知识点都整理上,还需要结合刷题才能查漏补缺,听课不可能做到对知识点的完全掌握)。概率论的强化完成也意味着数学强化阶段完成,接下来就不是看视频的事情了,而是全心投入刷题的过程中。关于刷题选什么题来刷、怎么刷、事件安排如何具体在实践中动态调整。数学和专业课基本上都进入刷题的阶段了,无论之前复习的效果如何,总之九月份一定需要开启刷题的状态;

一、随机事件与概率

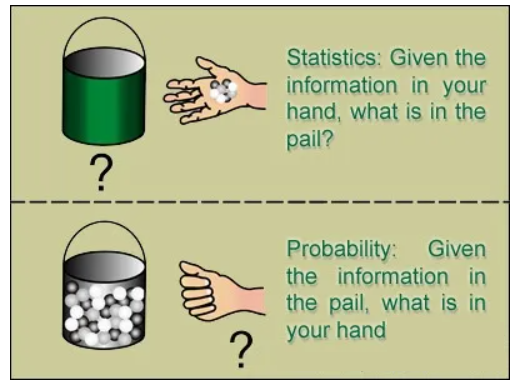

Q:概率论和数理统计的区别是什么?为什么常常将其合称为“概率统计”?

A:

概率论研究的是一个白箱子,你知道这个箱子的构造(里面有几个红球、几个白球,也就是所谓的分布函数),然后计算下一个摸出来的球是红球的概率;

数理统计面对的是一个黑箱子,你只看得到每次摸出来的是红球还是白球,然后需要猜测这个黑箱子的内部结构,例如红球和白球的比例是多少?(参数估计)能不能认为红球40%,白球60%?(假设检验);

概率论中的许多定理与结论,如大数定理、中心极限定理等保证了统计推断的合理性。做统计推断一般都需要对黑箱子做各种各样的假设,这些假设都是概率模型,统计推断实际上就是在估计概率模型的参数;

换句话说,概率论研究概率模型,数理统计挑选概率模型;

1.随机试验与随机事件

1.1 随机试验

称一个试验为随机试验如果满足:

(1)试验可以在相同的条件下重复进行;

(2)试验所有可能结果是明确可知道的,并且不止一个;

(3)每一次试验会出现哪一个结果,事先并不能确定;

抛硬币就是就是一个随机试验;

如果不能确切知道某一随机试验的全部可能结果,但是可以知道该结果不会超出某个值(这个范围甚至可以是(-∞,+∞)),此时也符合第二条件;

1.2 样本空间

随机试验的每一个不可再分的结果称为一个样本点(或基本事件),记为ω;

由样本点全体组成的集合称为样本空间(或基本事件空间),记为Ω;

抛硬币的样本空间Ω={正面,反面},其基本事件为w

1={正面},w2={反面};

1.3 随机事件

在随机试验中,可能出现也可能不出现的结果称为随机事件,简称为事件;

- 每次试验中一定会发生的事件称为必然事件,记为全集Ω;

- 每次试验中一定不发生的事件称为不可能事件,记为空集;

概率论中一个极其重要的基本功就是将题目中所给的基本事件用符号表示,这决定了后续解题的基础 – 一定注意是对基本事件进行符号化表示,比如令事件A为“抽到正品且通过验收”则这种设法是不妥当的,应当设事件B为“抽到正品”,事件C为“通过验收”。

1.3.1 事件的关系

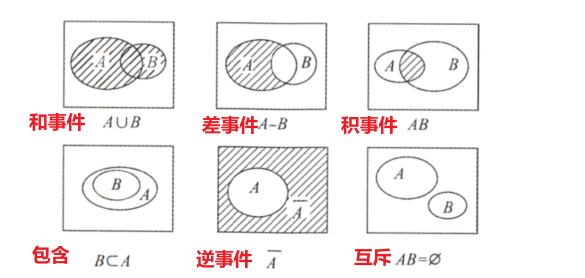

事件由集合定义,因此事件的运算本质上就是集合的运算;

事件的关系主要有:包含、相等、相容、互斥和对立;

事件的运算主要有:和,差,积;

(1)包含:如果事件A发生必然导致事件B发生,则称事件B包含事件A;

(2)相等:如果事件B包含事件A同时事件A包含事件B,则称事件A和事件B相等;

(3)事件的积/交:如果事件C是“事件A和事件B同时发生”的事件,则称事件C是事件A和B的积/交 – 可推出,A∩空集=空集,A∩Ω=A;

(4)相容:如果事件A和事件B的积/交不为空集,则称事件A和事件B相容;

(5)互斥:如果事件A和事件B的积/交为空集,则称事件A和事件B不相容/互斥,如果一堆事件中的任意两个事件都互斥,则称这些事件是两两互斥的;

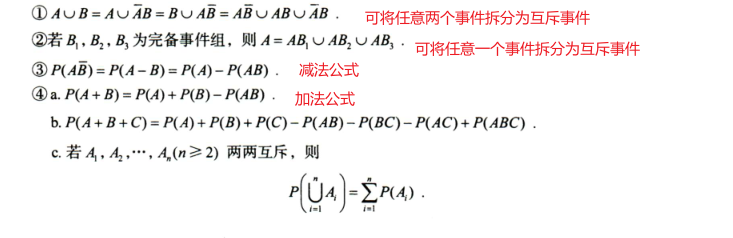

(6)事件的和/并:如果事件C是“事件A和事件B至少有一个发生”的事件,则称事件C是事件A和B的和/并 – 这个概念很重要,可推出A∪空集=A,A∪Ω=Ω;

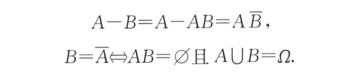

(7)差事件:如果事件C是“事件A发生但事件B不发生”的事件,则称事件C是事件A与B的差时间,记为A-B;

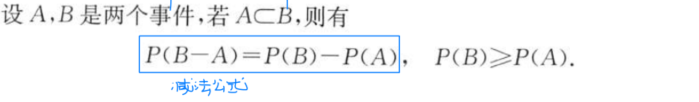

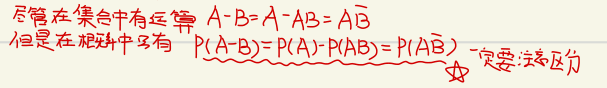

根据差事件的定义有如下两个性质成立

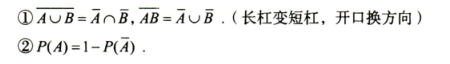

(8)逆事件/对立事件:如果事件是“事件A不发生”的事件,则称事件C是事件A的逆事件或对立事件;

- 事件的运算中有差运算A-B,但是没有A+B这种运算!!!和事件使用的是∪符号而不是+符号!!!

事件运算先后顺序约定为:逆运算、积运算,最后是和运算或差运算;

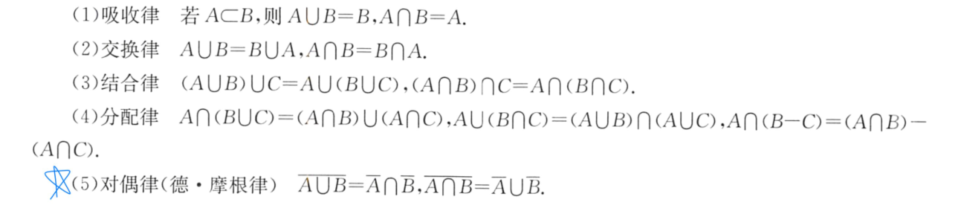

1.3.2 运算法则

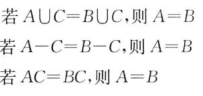

这里列出的运算法则是完全正确的,而其他未列出的运算法则必须以此推导,不能理所当然的认为存在;

事件的运算和数的运算是存在不同的!!!所以一定要注意不要理所当然的将数的运算法则类比到事件上,如下三个推导均是错误的

2.概率

2.1 基本概念

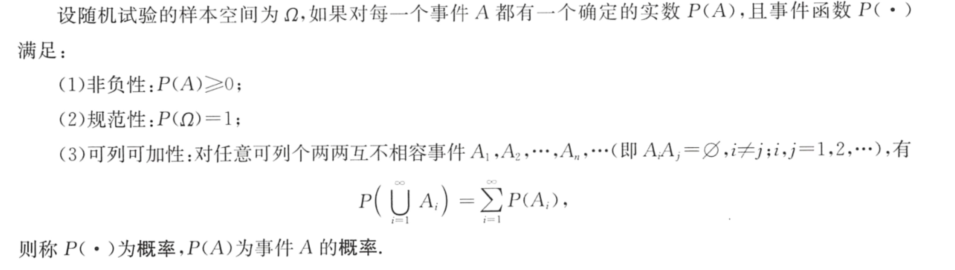

概率的公理化定义如下:

- 概率P(·)是事件的函数,输入为事件,输出为事件发生的概率;

- 概率的公理化定义并不能应用于计算,常用于该定义判断某事件函数P(·)是否是概率;

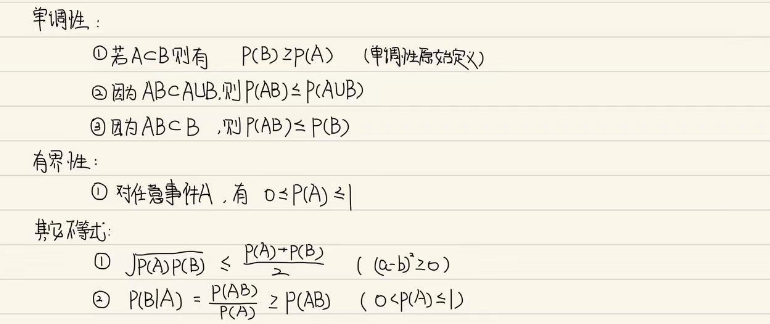

概率主要有以下两个性质性质

(1)有界性:对于任一事件A,有0<=P(A)<=1

不可能事件的概率为0,但是概率为0的事件不一定是不可能事件;

必然事件的概率为1,但是概率为1的事件不一定是必然事件;

(2)单调性:

单调性在解题过程中尤其重要,概率公式的变形主要有以下几种

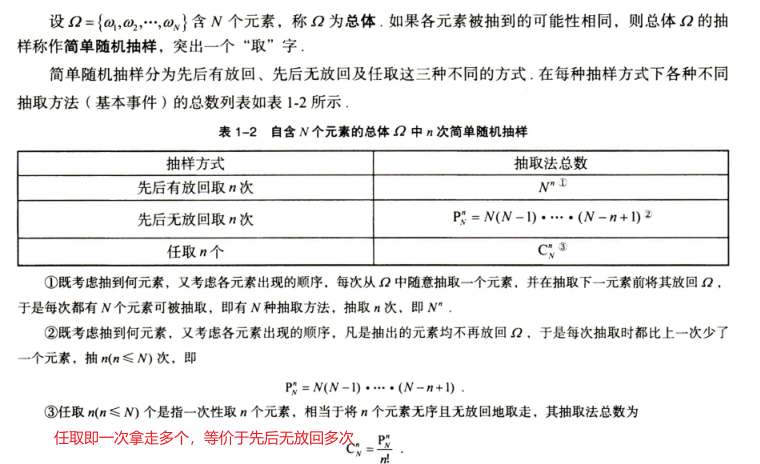

2.2 古典概型求概率

称随机试验的概率模型为古典概型,如果其样本空间满足:

- 只有有限个样本点(如抛硬币、掷色子);

- 每个样本点发生的可能性都一样(等可能性);

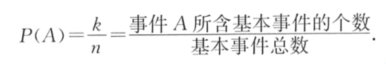

如果古典概型的基本事件总数为n,事件A包含k个基本事件,则事件A发生的概率为

关于古典概型的题型,考研数学中仅有如下两种题型(其他题型均可转化为该模型,且这两个模型之间也可以互相转换)

- 随机分配问题

- 简单随机抽样问题

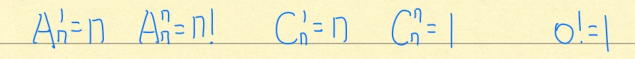

关于排列和组合,并不需要理解的特别透彻(这很容易导致做题的时候麻木,只需要知道组合是排列除以组内部的顺序即可),可以用三个水果选两个来画图直观理解;

- 排列P(n,m)带内部顺序;组合C(n,m)不带顺序,即排列除以内部顺序

无论是随机分配问题还是随机抽样问题,本质上还是借助古典概型的定义来求概率,即P(事件A)=基本事件数/基本事件总数,随机分配和随机抽样问题的区别就在于基本事件总数的计算方式不同;

这种题的难度都不会很大,不要再像高中一样去背什么捆绑法之类的,简单能够理解就行;

关于排列组合,如下比较重要的性质需要记忆(可加快某些计算的速度)

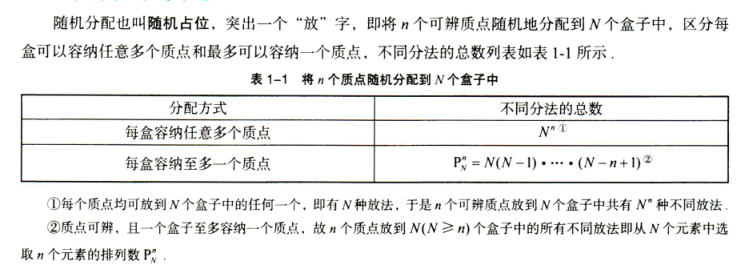

2.2.1 随机分配问题

- 注意题干中的修辞,“某指定n个盒子中各有一球”即只有一种情况,“恰有n个盒子各有一球”即需要随机抽取出n个盒子有组合数C(N,n)种情况

2.2.2 随机抽样问题

- “先后无放回取出k个球”与“任取k个球”的概率相同,利用这点可以将第二种类型的求解转换为第三种类型

- “抓阄模型”是一种重要的模型,即中奖的概率与买彩票的先后顺序无关,一般题干叙述“第三次取到白球”即为抓阄模型(无论是否有放回),题干叙述为“第三次才取到白球”即为乘法公式

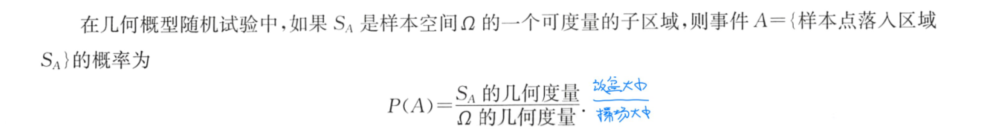

2.3 几何概型求概率

称随机试验的概率模型为几何概型,如果其样本空间满足:

- 样本空间Ω是一个可度量的有界区域(可度量指的是长度或面积);

- 每个样本点发生的可能性一样;

古典概型与几何概型的区别:基本事件有限、等可能发生的随机试验为古典概型;基本事件无限且具有几何度量、等可能发生的随机试验为几何概型;

2.4 重要公式求概率

(所有难以理解的概率公式都可以使用文氏图的方式画出来 – P(A)表示集合A的面积占全集Ω面积的比率)

2.4.1 对立思想

2.4.2 互斥思想

P(ABC^-^)=P(AB)-P(ABC) – 令AB=P即可推出;

注意P(AB^-^)!=P(A)-P(B)

事件的运算中只有和事件没有事件做加法运算

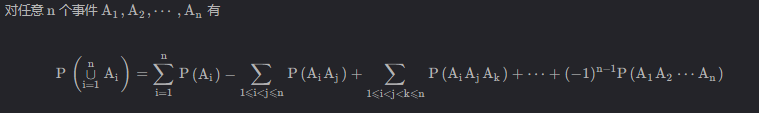

另外,对于大于3个以上事件的概率加法公式,也有记忆的必要,这里给出通式

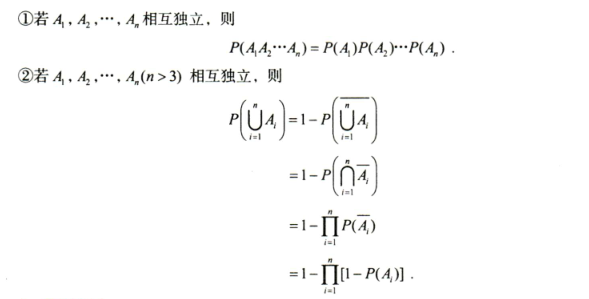

2.4.3 独立思想

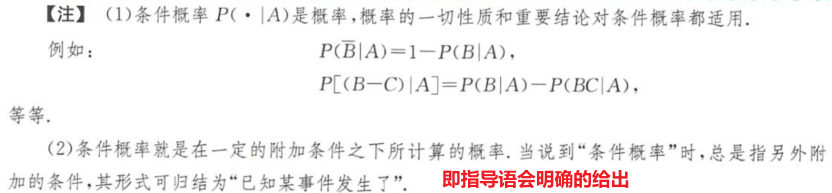

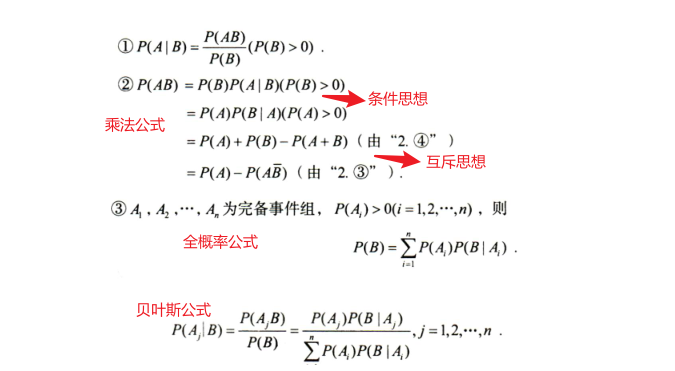

2.4.4 条件概率

- 乘法公式既可以使用条件概率的思想,也可以使用互斥思想,解题时需要同时想到;

- 乘法公式的拓展(同样做分母的概率需要大于0)

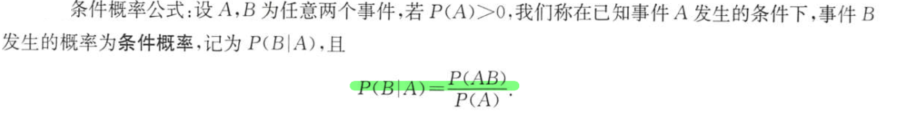

(1)条件概率公式

- 条件概率一定需要注意“垂帘听政”的事件的概率需要大于0

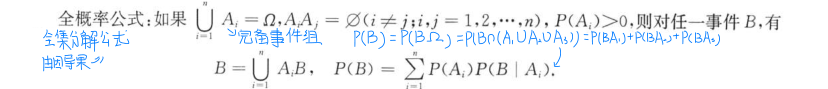

(2)全概率公式

全概率公式又称为全集分解公式,是一种“由因导果”的思想;

全概率公式的特点是,某事件的发生是可能在多种条件下的,而这些条件一起构成了一个完备事件组(当然这些条件可以是主观上与该事件没啥关系的事件,比如“(我去游泳|小明吃饭了)”,但是一旦两者以条件概率的形式写出来则两者就有了条件的这种关系)

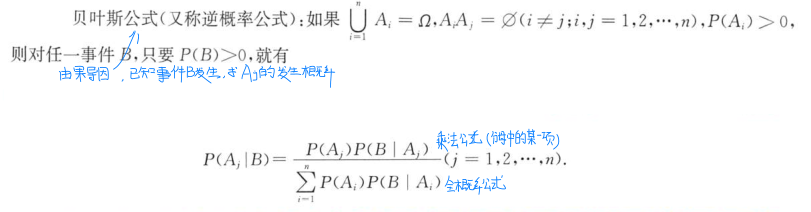

(3)贝叶斯公式

贝叶斯公式又称为逆概率公式,是一种“由果导因”的思想,即已知事件B发生,求事件Aj发生的概率

- 注意P(B)和P(B|A)的区别与联系对理解贝叶斯公式有很大作用,P(B)是在样本空间Ω下计算的事件B发生的概率,而P(B|A)是在已知事件A发生的条件下(也就是样本空间现在缩减为A)计算的;

- 贝叶斯的题型解题,两个无脑的步骤

- 基本事件变量化;

- 由已知条件求解所有基本事件的概率;

2.4.5 常用不等式

概率的等量关系如加法公式、减法公式等重要公式前面已经介绍过这里不再赘述,这里主要总结常用的概率不等式

2.4.6 最值思想

涉及最值的题目一般需要进行转换才能求解

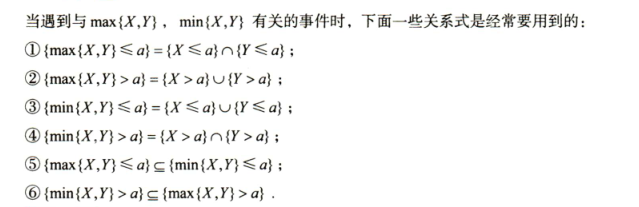

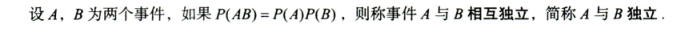

3.事件的独立性

3.1 独立的定义

两个事件独立的定义如下

- 不可能事件与任何事件(包括其他不可能事件)相互独立;

- 事件A与事件B相互独立则A的对立事件与B也相互独立;

多个事件的相互独立和两两独立的定义如下

- 互不相容/互斥事件可以简化并事件的概率计算:P(A

1∪A2∪…∪An)=P(A1)+P(A2)+…+P(An);- 相互独立可以简化交事件的概率计算:P(A

1∩A2∩…∩An)=P(A1)P(A2)…P(An);

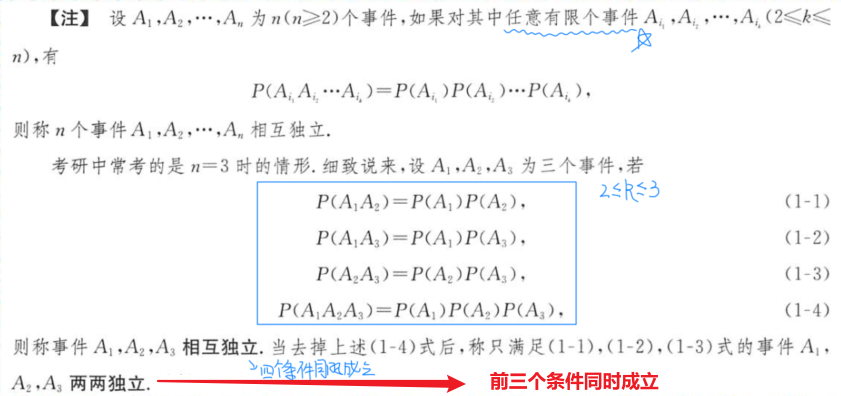

3.2 独立的判定

- 独立的等价说法是,无论事件B是否发生都不会影响A的发生,则事件A,B相互独立(第四点)

- 独立不具备传递性;

- 判断事件是否独立,不要用主观常识去判断,一定举例代入公式计算得出结论;

二、一维随机变量及其分布

1.基本概念

随机变量的意义在于统一和量化事件 – 原本使用集合来定义事件,这导致很难用数学方法来分析。因此引入随机变量函数的概念,将不确定的各种事件ω通过随机变量函数X(ω)映射到实数轴,进而统一分析

1.1 随机变量

定义:随机变量X(ω)是一个定义在Ω上的实值单值

函数,即该函数的定义域是样本空间Ω(注意其定义域不一定是实数集,可以是任何事件集合),值域是实数轴;

该函数的自变量ω是样本空间Ω中的基本事件,之所以称该函数为随机变量就是因为自变量ω的出现是有一定的概率,因此其对应的函数值也是随机出现的,需要与普通函数的x是一个确定值区分;

正因为自变量ω不是一个确定的值,因此不能使用微积分工具来研究随机变量函数的性质,于是引出了研究随机变量的工具 – 分布函数;

(一般的,随机变量函数X(ω)我们简称为随机变量X,因为之后的所有研究对象都是函数值X所以可以忽略自变量ω)

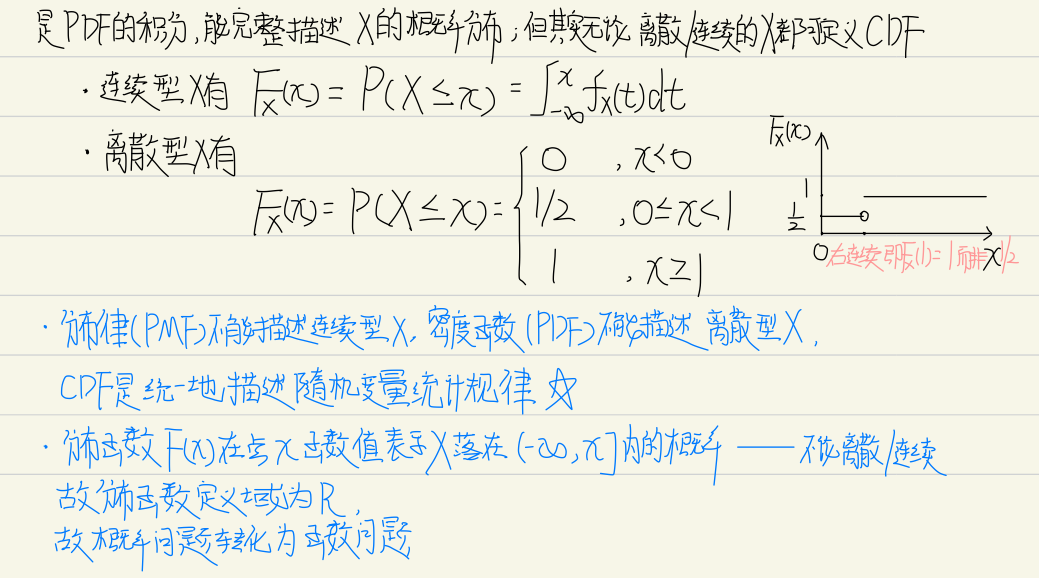

1.2 分布函数

1.2.1 分布函数的定义

定义:设X是随机变量,x是任意实数,则称函数

F(x)=P{X<=x}(x∈R)为随机变量X的分布函数,也称X服从分布F(x)分布,记为X~F(x)

关于上述定义需要说明:

- 随机变量X的定义域是Ω,但是

任何分布函数F(x)的定义域都是R,也就是x属于(-∞,+∞),在后续解题过程中一定要考虑这点然后分情况处理; - 分布函数的x从-∞取值到+∞对应ω从空集取值到Ω;

- 因为分布函数F(x)中的x是一个确定值,因此可以研究其相关性质;

- 分布函数的泛化写法如下(很重要)

$$

P(狗<=猫)=F狗(猫)

$$

1.2.2 分布函数的性质

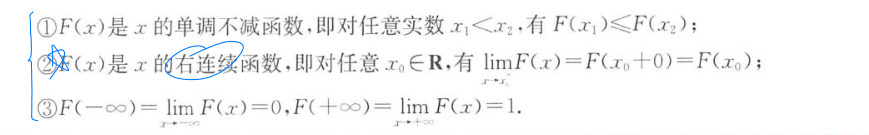

分布函数主要有以下五条基本性质(无论是离散还是连续都有这样的结论,这也是分布函数的充要条件)

(4)分布函数本质上是事件的概率,即P{X<=x},因此有0<=F(x)<=1,即任何分布函数都是有界函数;

(5)离散型随机变量的分布函数是阶梯状的(对应阶梯图像右连续,右连续是指函数f(x)在x0点的取值与limx->x0^+^f(x)是相同的),连续型随机变量的分布函数是连续的(其概率密度函数f(x)不一定连续)

1.2.3 分布函数的应用

分布函数一个简单且重要的应用是求概率

注意:

- 关于分布函数右连续这个性质,在解题的过程中非常重要,尤其是在写离散型随机变量的分布函数的时候,区间应该写作[a,b)这样做出的阶梯图像才是右连续的!!!

- 关于随机变量X和Y同分布(即X和Y都服从相同的分布函数)

- 若题干告知X和Y同分布,则表示X和Y的分布函数相同,但并不意味着X和Y的概率密度函数也相同

- 若题干告知随即变量X=Y则两个变量一定同分布且概率密度函数相同

- 有相同的期望和方差,两个随机变量未必服从相同的分布

2.常见随机变量

离散型随机变量与连续型随机变量的不同之处:

分布律是指X取每个值对应的概率,是离散型随机变量特有的;

概率密度函数类似于分布律,同样也是每个X值对应的概率,是连续型随机变量特有的;

离散型随机变量的分布律与分布函数互相唯一确定,但对于连续型随机变量来说,其概率密度函数f(x)唯一确定分布函数F(x),但分布函数F(x)对应多个概率密度函数f(x)(有限个点取值不影响积分取值)

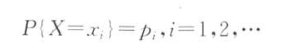

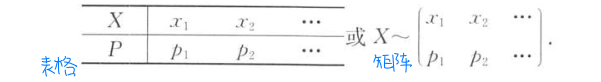

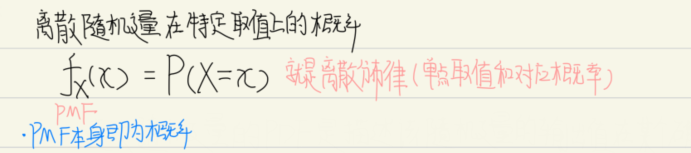

2.1 离散型随机变量

定义:如果随机变量X的取值是有限个或可列个值,则称X为离散型随机变量(反之,称X为[连续型随机变量](# 2.2 连续型随机变量));

假如随机变量X是离散型随机变量,则X的分布律、分布列或概率分布如下(即X取每个值的概率)

X的分布律常记为X服从pi,一般使用表格或矩阵来表示

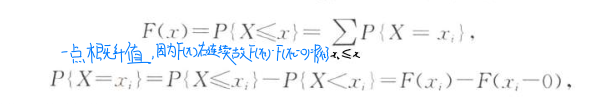

X的分布函数定义如下

离散型随机变量利用分布函数计算其在区间上的概率方式如下

借助分布函数,可以非常精准的求解概率如

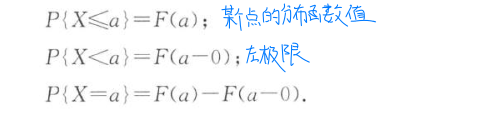

- P{X<=a}=F(a)

- P{X<a}=F(a-0)

- P{X=a}=F(a)-F(a-0)

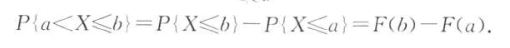

- P{a<X<=b}=F(b)-F(a)

上面这四个公式是基础公式,可由它们演化出如下公式(抓住F(x)=P{X<=x}这一基本定义)

- P{X>a}=1-P{X<=a}=1-F(a)

- P{a<=X<=b}=F(b)-F(a-0)

- P{a<X<b}=F(b-0)-F(a)

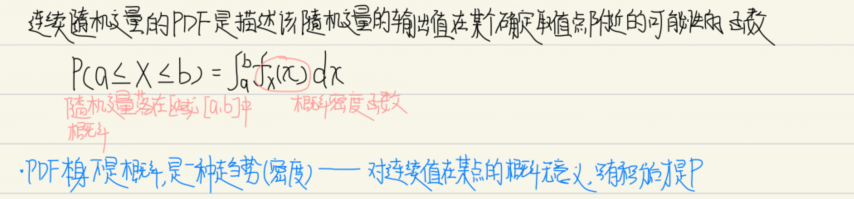

2.2 连续型随机变量

定义:如果X的分布函数的形式为

其中f(t)是非负可积的函数,则称X为连续型随机变量,同时称f(t)为X的概率密度函数,记为X~f(t)

- 上述定义中,

f(x)为某随机变量X的概率密度函数的充要条件是f(x)>=0且f(x)在-∞到+∞上的积分为1; - 为什么不类似离散型的定义那样,直接定义连续型随机变量X为取值连续的变量?因为连续型随机变量在某点的取值根本就测不到,更别说用每一点来对其进行定义;

关于连续型随机变量:

- 连续型随机变量在任意一点的概率都为0;

- 连续型随机变量的分布函数一定是连续的(但其对应的概率密度函数f(t)不一定是连续的)

连续型随机变量利用分布函数计算其在区间上的概率方式如下(连续随机变量的概率计算公式简单得多,因为在点上的概率为0所以无需考虑等号)

2.3 概念辨析

2.3.1 常见问题

Q:离散型随机变量嗯好连续型随机变量的本质区别在哪里?

A:本质区别就在于随机变量的取值是“离散”的还是“连续”的;离散和连续是两个相对的概念,离散是指任取两个数字,其中间只会有有限个数字。不是离散的就一定是连续的(至少现阶段可以这样认为);

另外需要注意一点,连续并不意味着无法取得其中的某个值,比如对于在连续的实数轴上,我们可以任意取出某个点对应的某个值;

Q:几何概型和连续型随机变量究竟有没有什么关系?

A:在考研数学中我们认为这两个概念没有任何关系 – 唯一相似之处就是两者的概念中都会出现“连续”;

- 连续型

随机变量的取值是连续的,而几何概型的概率的取值也是连续的,这并不意味着两者之间有什么关系;

当然还有人可能会说,几何概型在某点取值的概率与连续型随机变量在某点取值的概率都是0,这难道不是两者之间的联系吗?实际上这两个“点”都不是同一个概念上的点;

-

几何概型在某点取值的概率为0是因为某点的测度为0作为分子因此结果为0;

- 连续型随机变量之所以在某点取值的概率为0是因为在计算概率(分布函数)的公式中会用到积分,而当积分的上下限都是该点的时候自然计算出的结果也是0(至于常说的“测不到”,以后别这么用,这个说法不标准,容易引起混淆 – 因为上述两种情况都可以说是测不到);

- 注意一点,硬要给两者攀关系的话,因为连续型随机变量的取值是连续的,这意味着是可以对应几何度量的,因此连续型随机变量在某点的概率取值为0对应了几何度量中的0作为分子(因为点的长度为0);从这个角度来看连续型随机变量和几何概型还真有联系 – 这也是为什么在这个概念上纠结了一个多小时,因为两者看似没有关系实际上又有关系…而实际上两者的联系也就仅仅如此而已,所以一般为了不混淆,我们索性认为这两个概念根本没有联系,解题的时候用各自的公式求解;

从教材上最原始的定义理解,两者也是没有关系的:

- 几何概型的前提是事件必须有几何度量;

- 连续型随机变量的定义只对事件对应的函数值做了要求,而对事件本身并没有任何限制;

综上,在考研概率论中,为了避免不必要的麻烦,我们认为几何概型和连续型随机变量没有任何关系;

2.3.2 易混概念

从另一种角度来理解离散型随机变量和连续型随机变量

(1)概率密度函数(PDF)

概率密度函数本身不是概率,因此其取值可以大于1;

(2)概率质量函数(PMF)

概率质量函数本身就代表对应的离散值的概率,因此其取值范围一定在[0,1];

(3)积累分布函数(CDF)

积累分布函数的本质也是概率,因此其取值也限定在[0,1];

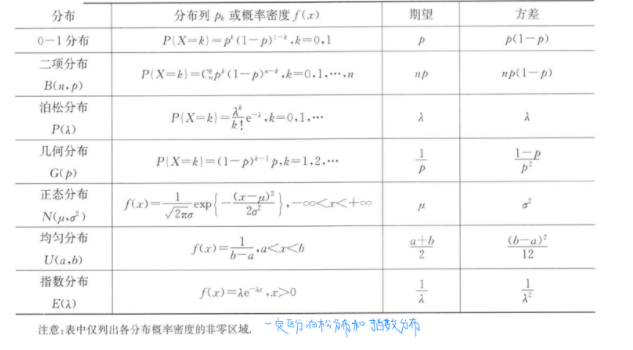

3.八大分布

概率论八大分布是数理统计中最常用的概率分布(概率分布是指用于表述随机变量取值的概率规律),它们可以用来研究各种随机现象,并影响着大量实际问题的解决方案,以度量其实际应用的准确性。因此,深入理解概率论八大分布是数理统计和实际应用上的必要,也是重要的一步。(随机变量的分布并不等价于随机变量的分布函数,注意区分!!!)

需要注意的是,此处给出的八大分布只是最经典、最基础的分布,而考研题型中可能出现拓展或对经典分布的一般化(故不要随意将经典分布的结论用到未知分布上),解题的立足点都是基于经典分布做推导

3.1 离散型分布

3.1.1 两点分布_B(1,p)

在介绍0-1分布之前先介绍伯努利试验,先从独立试验开始说起;

- 独立试验:如果试验的结果之间相互独立则称试验相互独立;

- 独立试验序列:在同样条件下独立重复地进行一系列完全相同的试验,即每次试验的可能结果及其发生的概率都不变,每次试验是相互独立的,称这种重复试验序列的数学模型为独立试验序列概型;

- 伯努利试验:在独立试验的基础上,如果每次试验只有两个结果且互为对立事件,则称该试验为伯努利试验,将伯努利试验独立重复地进行n次称为n重伯努利试验,总结伯努利试验的特点

- 只有两种对立的结果;

- 各次试验相互独立;

- 各次试验成功的概率相同;

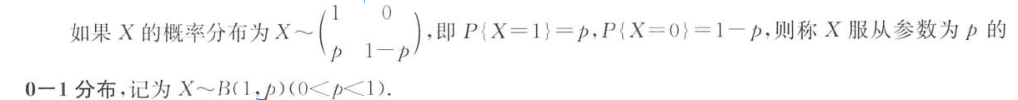

0-1分布就是一重伯努利试验,也称为Ber-E/两点分布

定义:

0-1分布有如下重要性质(解题思想)

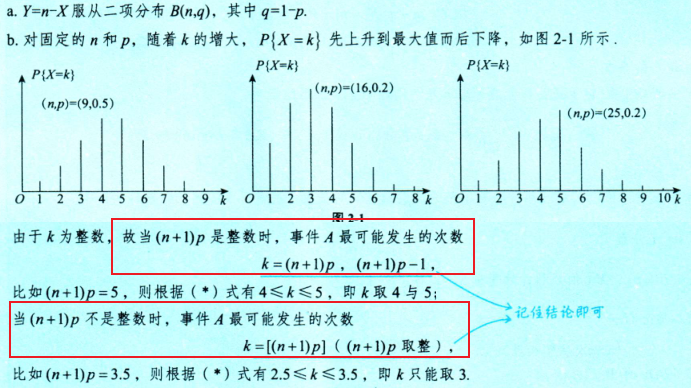

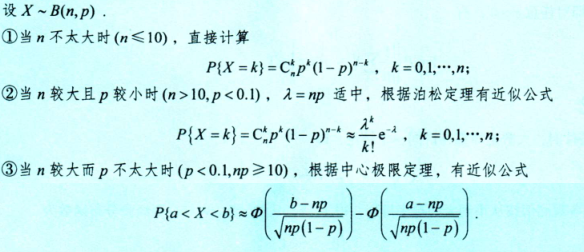

3.1.2 二项分布_B(n,p)

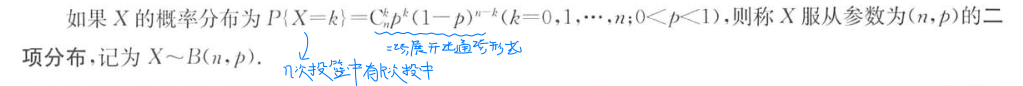

二项分布也称为Ber-En分布,上面介绍的两点分布实际上是一种特殊的二项分布,即n=1时的二项分布,二项分布的定义如下

定义:

- n重伯努利试验服从二项分布,若X是n重伯努利试验中事件A发生的次数,则X~B(n,p),其中p=P(A);

二项分布的三种计算方法(后两种一个适用于X具体取值,一个适用于X在某一个范围)

3.1.3 泊松分布_P(λ)

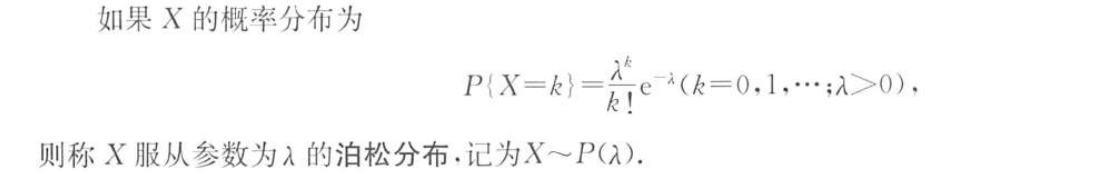

泊松分布的理解:某场合下,单位时间内质点来流个数为X(X为自然数),参数λ称为强度,则随机变量X服从泊松分布P(λ),且E(X)=λ,即单位时间内质点来流的平均个数为λ

定义:

- 注意泊松分布的k值是非负整数(不能有半个人也不能有负人…)

- 泊松分布的公式是少数无法直接用自然语言转换的、需要强行记忆的公式;

- 举实例理解泊松分布,某交叉路口的汽车流可看作泊松分布,其中X表示一分钟(单位时间)内汽车通过的数量,假如题目告知一分钟内有汽车通过的概率P{X>=1}=0.7,则可依据公式求解出强度λ;

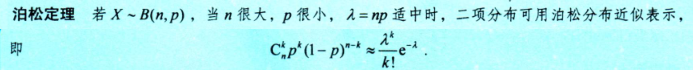

关于泊松分布,考研大纲要求需要掌握泊松定理(常用于将复杂二项分布转换为可计算的泊松分布)

3.1.4 几何分布_G(p)

几何分布也称为Ber-E∞分布,这并不意味着进行无穷次伯努利试验,而是重复进行伯努利试验当首次命中时即停止

- 几何分布与几何没有任何关系(但是几何概型与几何有关系);

- 几何分布是一种离散型的等待分布;

定义:

- 设X表示伯努利试验中事件A首次发生所需做的试验次数,则X~G(p),其中p=P(A)

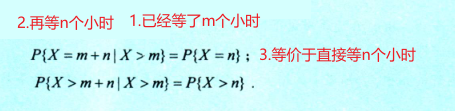

积分分布具有无记忆性,当m,n均大于0时有如下结论

3.1.5 超几何分布_H(n,N,M)

定义:

超几何分布常常出现在从一个有限总体中不放回的随机抽样,其中的N表示产品总数,M表示其中的不合格品数量,n表示不放回的随机抽取数量,k表示抽取到的不合格产品的数量(关于k的取值范围实在是没必要记忆,理解为抽取到的不合格产品的数量即可)

3.2 连续型分布

注意连续型分布的概率密度函数的定义域端点值可取可不取,这点需要与分布函数定义域的左闭右开做区分!!! – 换句话说连续型随机变量的概率密度函数的定义域有没有等号都是对的,也就是说(a,b),[a,b]甚至(a,b]或者[a,b)都是正确的写法,因为连续函数在有限个点的取值根本测不到,也不会影响最终的分布函数

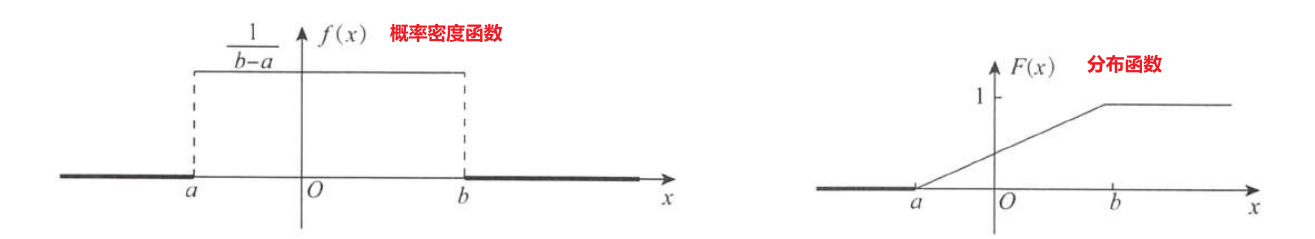

3.2.1 均匀分布_U(a,b)

均匀分布的背景是一维的几何概型,即概率计算方式为测度之比 – 若题目明确说明了随机变量X在区间(a,b)是服从均匀分布的,则在这段区间上的f(x)一定不为0且相等

均匀分布的另一种等价提法“X在I上的任一子区间取值的概率与该子区间长度成正比”

定义:

- 求解均匀分布的一个重要性质是F((a+b)/2)=P{X<=(a+b)/2}=1/2;

- 均匀分布的另一个重要性质是其概率密度函数一旦有值则在区间(a,b)上一直有值直到结束;

- 换句话说,当x<a时(即起点左边)有F(x)=0,x>b时(即起点右边)有F(x)=1

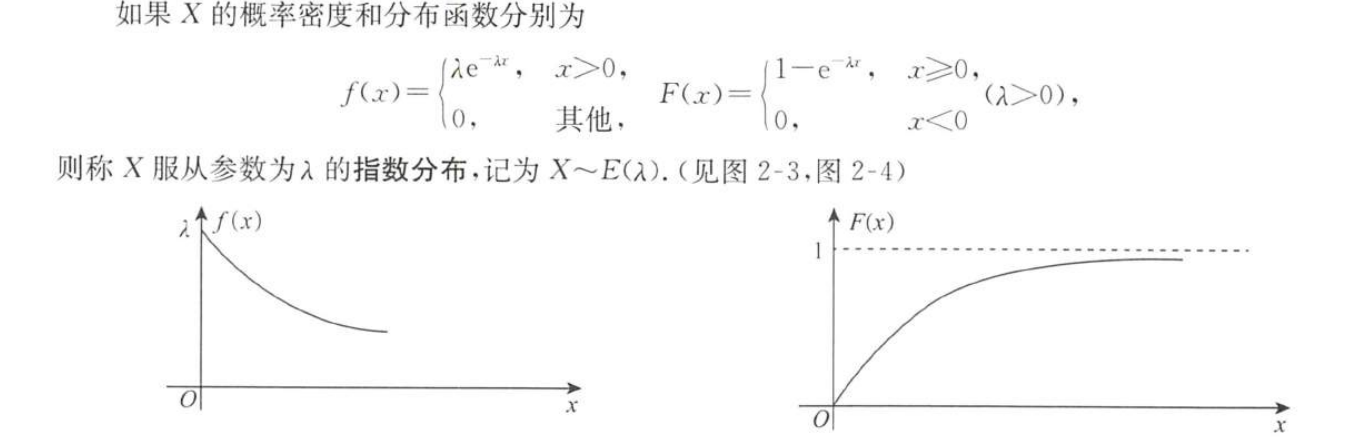

3.2.2 指数分布_E(λ)

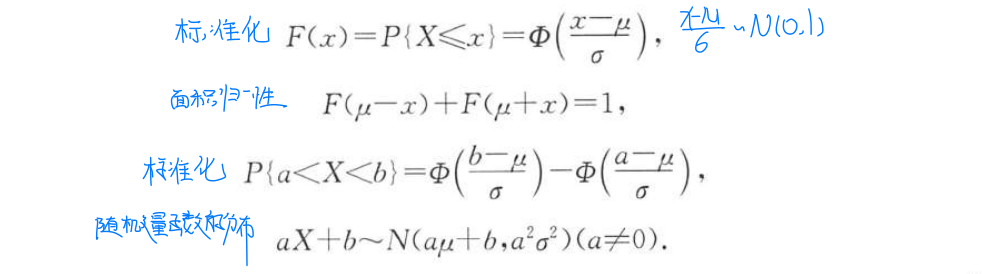

指数分布是连续型等待分布(与几何分布区分),计时方式是连续的,其中λ是失效率(失效率与平均等待时间呈倒数关系),有E(X)=1/λ

定义:

- 假设某元件的工作寿命X(小时)服从参数为λ的指数分布,则该元件正常工作t小时的概率为P{X>t}=1-F(t);

- 指数分布具有无记忆性(在无耗损,即失效率不变的情况下),这意味着元件继续正常工作10小时的概率P{X>10}与其之前的工作状态无关,即P{X>10+已工作时长|X已工作时长}=P{X>10};

指数函数的重要性质

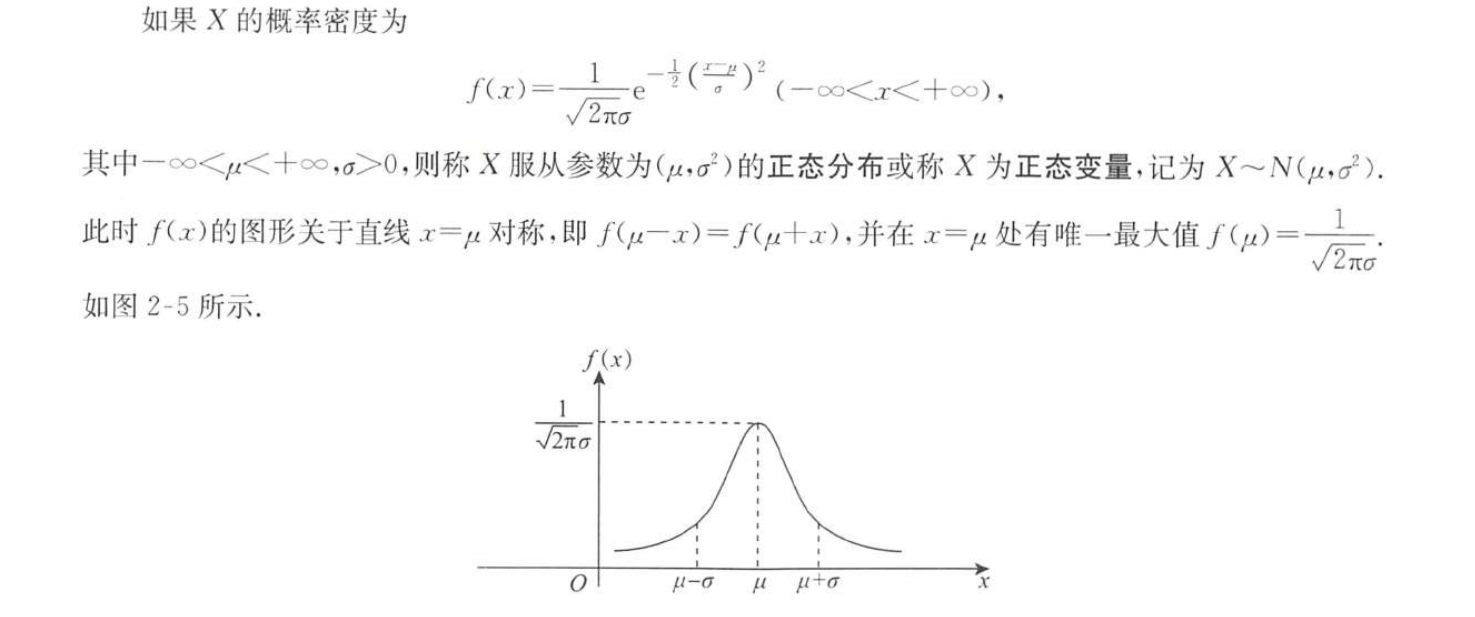

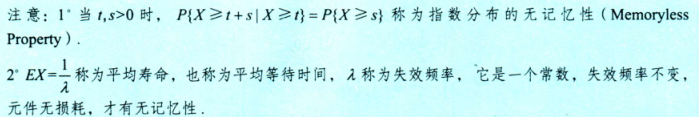

3.2.3 正态分布_N(μ,σ^2^)

正态分布是最重要的分布,在后面会介绍,所有的分布最终都会趋于正态分布

正态分布的定义:

- 正态分布曲线图,均值不变,方差越大,图像越低,随机变量的取值越分散(因为方差的本质就是表示随机变量取值的分散程度)

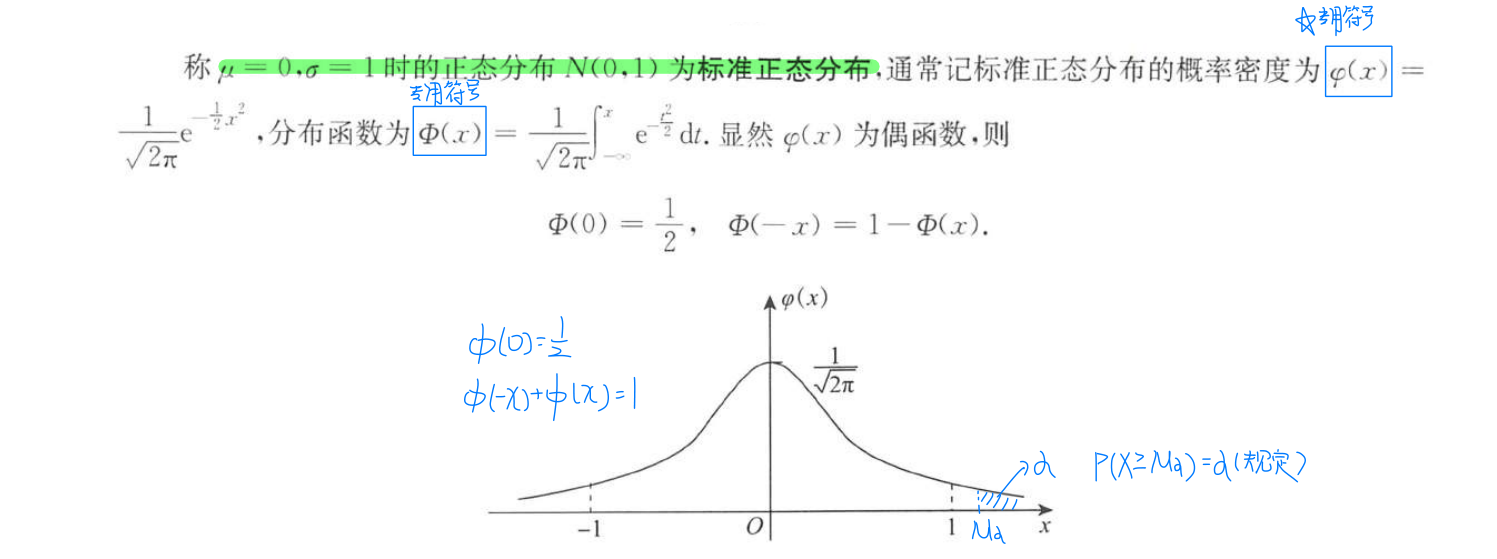

标准正态分布的定义:

关于正态分布主要有以下结论:

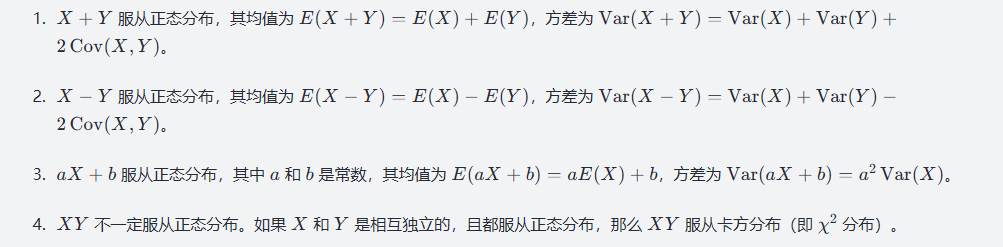

如果随机变量X和Y分别都服从正态分布即X~N且Y~N,则有以下结论

4.一维随机变量函数的分布*

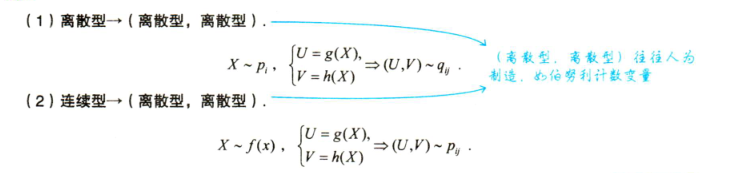

设X为随机变量,有函数/对应法则y=g(x),则称Y=g(X)函数为以随机变量X为自变量的函数,该函数仍然是随机变量。因为随机变量的函数仍然是随机变量,所以仍然可以研究其分布。这部分的问题主要分为三类:

- 离散型->离散型

- 连续型->连续型/混合型(一般地,所谓混合型指的是,因变量在区间端点离散取值,在区间内部连续取值,即同时具有连续型和离散型随机变量的特征)

- 连续型->离散型

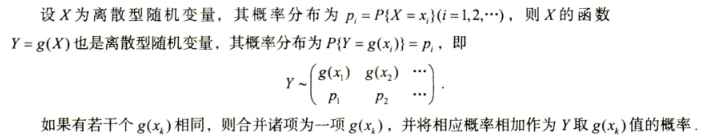

4.1 离散型->离散型

4.2 连续型->连续型/混合型

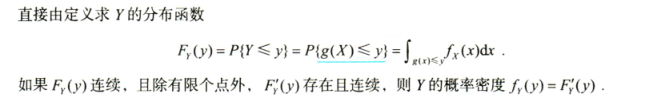

4.2.1 分布函数法

分布函数法实际就是利用分布函数的定义来解题

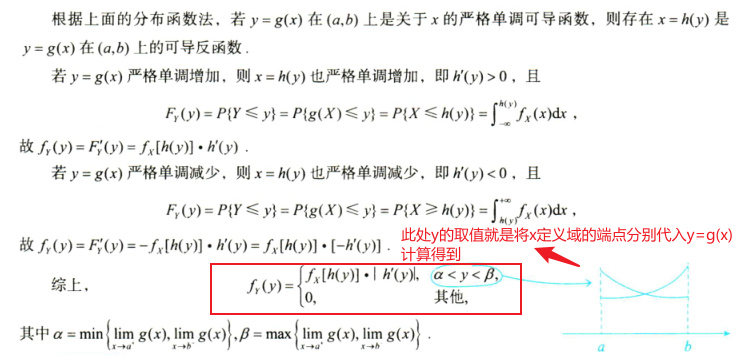

- 当对应法则y=g(x)在正概密区间上单调时,可以由分布函数法推出公式法

- 当对应法则y=g(x)在正概密区间上不单调时,一般作图,根据曲线Y=g(X)在直线Y=y的下方求解出X的取值范围,进而解题

4.2.2 公式法

公式法的核心就是不等号两边同时取反函数,假如对应法则在区间上单调减则需要改变不等号的方向

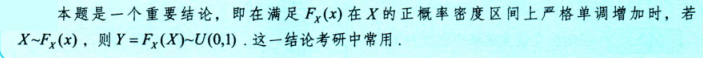

4.2.3 重要结论

- 当对应法则为X的分布函数时,Y服从(0,1)上的均匀分布(前提是X的分布函数在X的正概密区间上单调增)

4.3 连续型->离散型

- 这种情况下的对应法则一般都是人为制造的法则,比如取整函数;

4.4 补充知识点

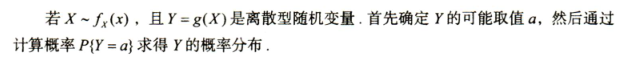

一些特殊的独立同分布的随机变量,其和的分布也是同类型的(前面说的正态分布也有这个性质),分别如下

上述结果对n个相互独立的随机变量也成立

第三讲 多维随机变量及其分布

显然一维随机变量只能表示单个特征,为了表示多维特征,因此需要引入多维随机变量,一般以研究二维随机变量为主。

1.基本概念

一维随机变量的定义:随机变量X(ω)是一个定义在Ω上的实值单值函数,即该函数的定义域是样本空间Ω(注意其定义域不一定是实数集),值域是实数轴;

n维随机变量的定义:若X

1,X2…Xn是定义在同一个样本空间Ω上的n个一维随机变量,则称(X1,X2…Xn)为n维随机变量或n维随机向量;

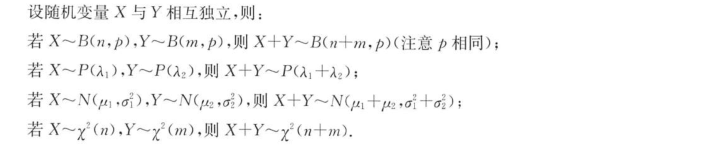

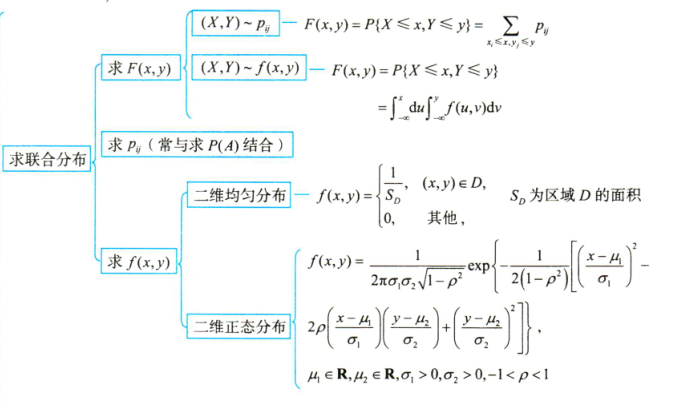

本章的核心知识框架如下

(离散型,连续型)的二维随机变量(二维混合型,注意与一维混合型的区别)会在多维随机变量函数的分布那一节的知识点中考察,使用分布函数搭配全集分解思想/等价事件求解即可;

分布律是指X取每个值对应的概率,是离散型随机变量特有的;

概率密度函数类似于分布律,同样也是每个X值对应的概率,是连续型随机变量特有的;

1.1 联合分布

求解联合分布主要涉及求解联合分布函数、联合分布律(结合古典概型)或联合概率密度

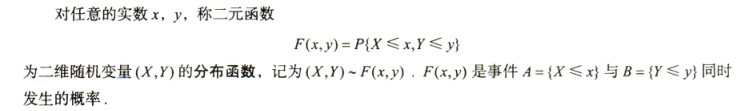

1.1.1 联合分布函数

- 对于二维随机变量(X,Y)来说,其联合分布函数为F(x,y),F(x,y)是事件A={X<=x}与B={Y<=y}同时发生的概率,即F(x,y)=P(AB);

F(x,y)是联合分布函数的充要条件如下(即联合分布的性质)

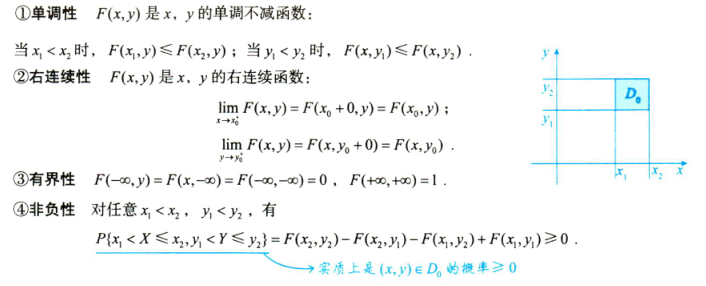

(1)离散型求联合分布函数

题干给出二维随机变量(X,Y)的分布律,求(X,Y)的分布函数F(x,y),为了不重不漏,主要遵循以下步骤:

- 划分平面区域:离散型的所有可能取值点(集中点)以及坐标原点,以所有的点为起点,向上和向右划分区域

- 分情况讨论:使用“锄头”每个区域依次讨论,F(x,y)为处于“锄头”左下方区域中的取值点的概率求和

(2)连续型求联合分布函数

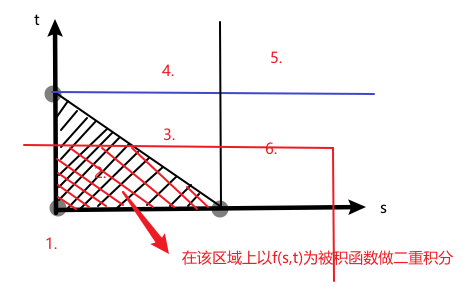

已知二维随机变量(X,Y)的概率密度f(x,y),求解(X,Y)的分布函数F(x,y),具体步骤如下:

- 坐标轴换元,将x轴换为s,y轴换为t,方便后序求解积分

- 划分区域:正概率密度区间与坐标轴相交的点(交点)和坐标原点,以所有的点为起点,向上和向右划分区域

- 分情况讨论:移动“锄头”,计算“锄头”与正概密区域围成的积分区域的二重积分即为F(x,y)

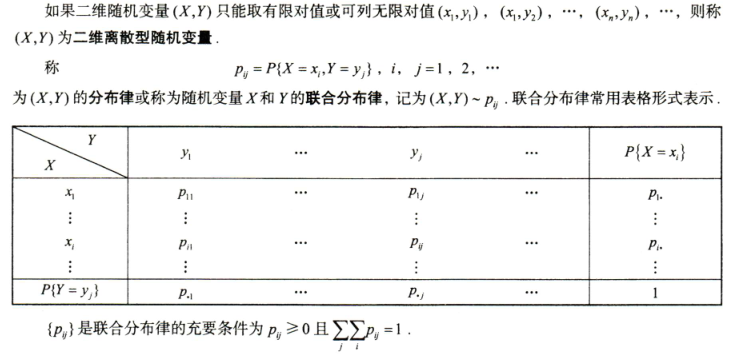

1.1.2 联合分布律

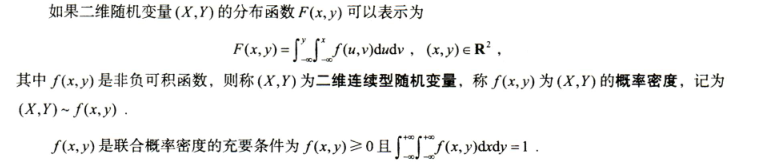

1.1.3 联合概率密度

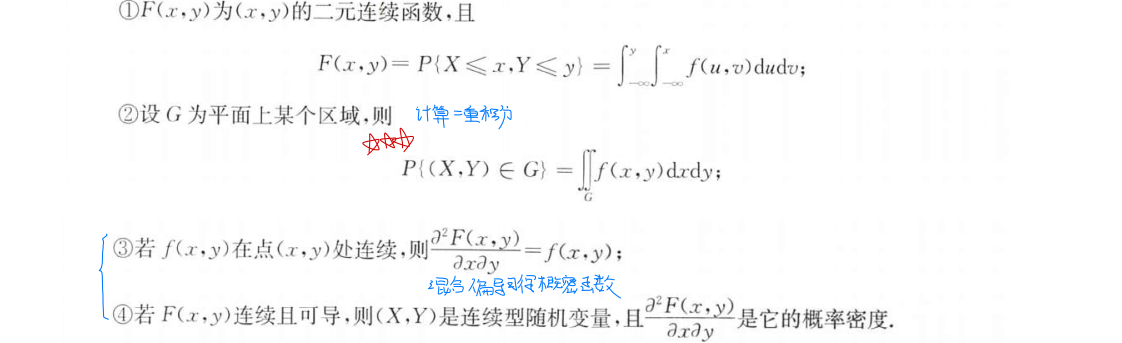

若(X,Y)的联合分布函数为F(x,y),联合概率密度函数为f(x,y),则有如下性质成立

- 上述混合求偏导的时候,对谁先求偏导没有要求(结果都是一样的),注意x和y是两个没有关系的变量因此不会有链式法则的出现;

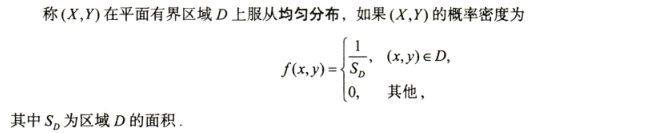

(1)二维均匀分布

- 二维均匀分布的背景是二维几何概型(即“操场掉馅饼,用碗接”)

- 关于二维均匀分布,很多人会在f(x,y)的区间为开区间还是闭区间上纠结,实际上开区间和闭区间都是正确的,但是习惯上都写作开区间;

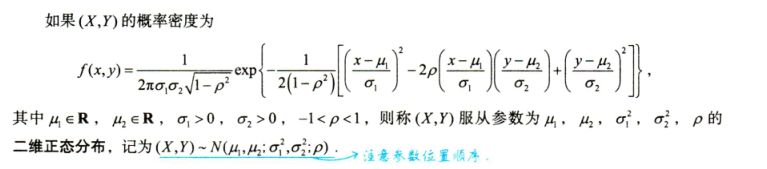

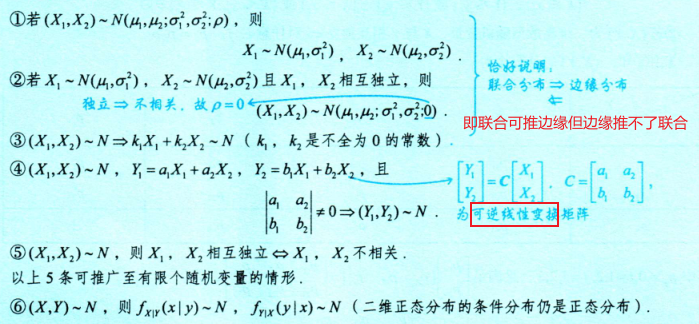

(2)二维正态分布

关于二维正态分布,有如下重要性质

- 若X和Y的联合分布是二维正态分布,则其边缘分布、条件分布以及线性组合aX+bY(a!=0或b!=0)都服从正态分布

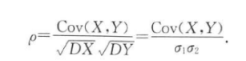

- 其中ρ是X和Y的相关系数,计算公式如下。X和Y相互独立的充分必要条件是X和Y不相关即ρ=0

1.2 边缘分布

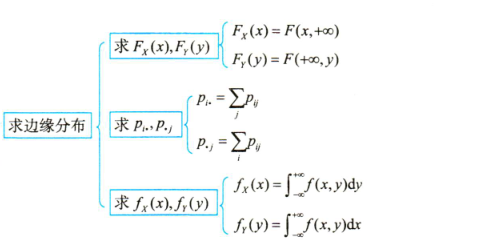

求解边缘分布主要涉及求解边缘分布函数、边缘概率密度以及边缘分布律

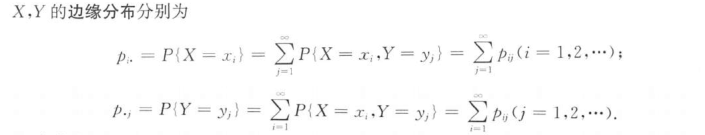

1.2.1 边缘分布律

1.2.2 边缘概率密度

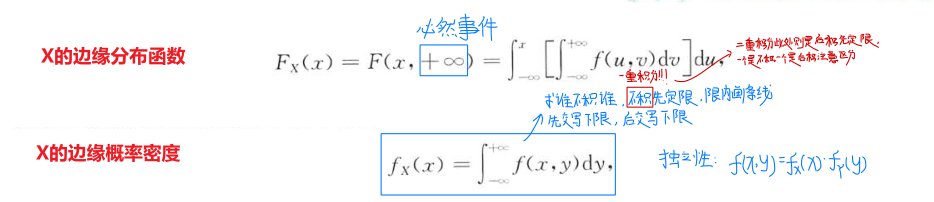

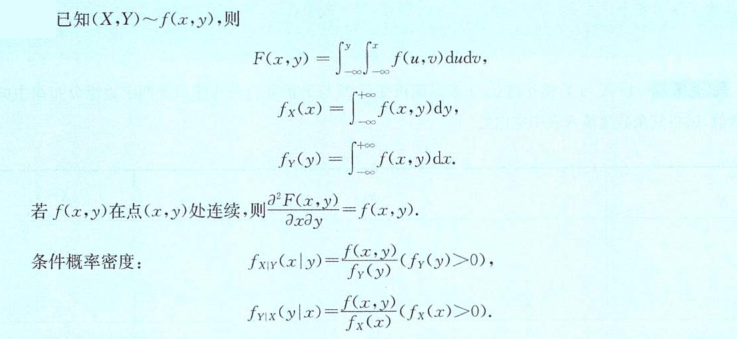

若(X,Y)~f(x,y),则X的边缘分布函数和边缘密度函数分别为(Y的边缘分布函数和边缘密度函数同理)

边缘概率密度函数的计算如果直接从高数的思维来理解很容易绕晕,这里的口诀就是用于快速计算边缘概率密度的,不要把它和高数中的二重积分或者一重积分的几何运用搞混;

- 其中“不积先定限”指的不是上下限,而是

范围限(这就是和二重积分的区别),尽管该一重积分形式上是负无穷到正无穷,但实际上只有在区域内的被积函数不为0,其余为0的范围就算再大算出来的面积也只能是0无意义;- 边缘密度函数的图像仅仅只是为了确定有意义的范围限,并要求去使用一重积分计算几何区域的面积,所以使用一重积分的思想就是无稽之谈;

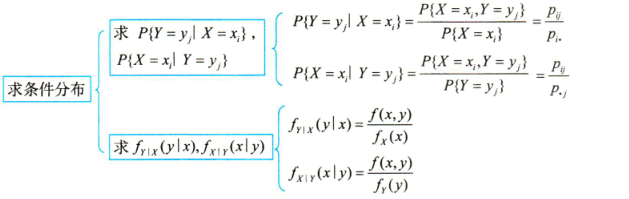

1.3 条件分布

求解条件分布主要涉及求解条件分布律或条件概率密度

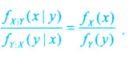

- 上述联合概率密度联立可得如下公式,其意义为使用两个条件概率密度可完全分离x和y两个变量

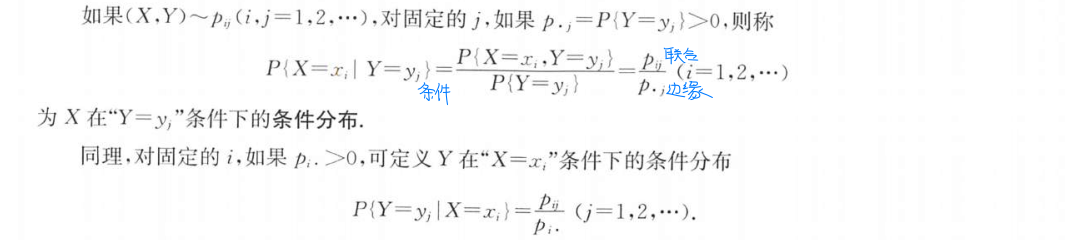

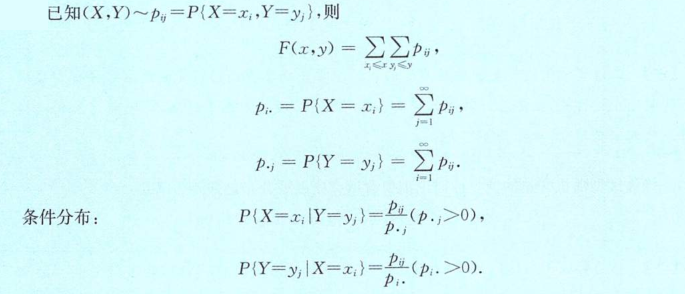

1.3.1 条件分布律

二维离散型随机变量的条件分布律的定义如下

1.3.2 条件概率密度

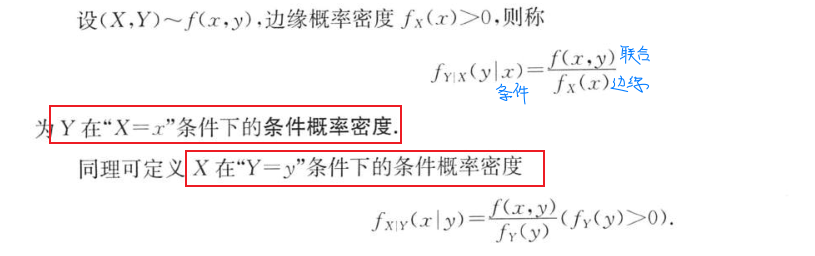

若(X,Y)~f(x,y),则条件概率密度函数的定义如下

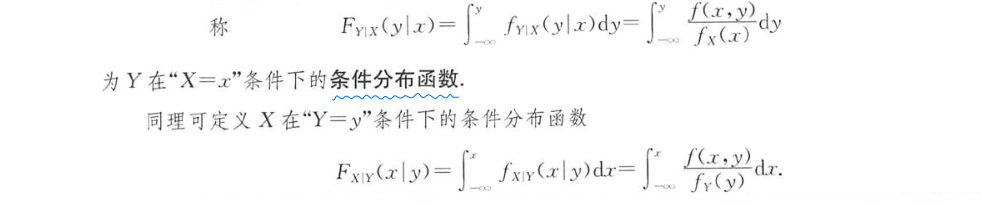

二维连续型随机变量的条件分布函数的定义如下

1.3.3 亚当-夏娃公式

该公式适用于有条件分布的题型,根据全集分解思想推导而来

1.4 小结

已知(X,Y)的联合分布(包括联合分布函数F(x,y),联合概率密度函数f(x,y),以及联合分布律pij),则可以确定边缘分布(包括边缘分布函数、边缘概率密度函数以及边缘分布律)和条件分布(包括条件分布函数、条件分布律或条件概率密度函数)。反之,仅知道边缘分布无法确定其联合分布(除非附加其他条件)

(1)离散型随机变量的联合分布与边缘分布、条件分布之间的转换

(2)连续型随机变量的联合分布与边缘分布、条件分布之间的转换

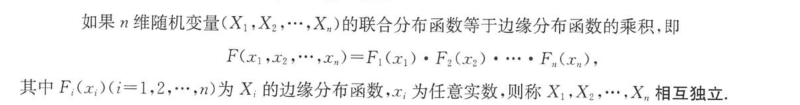

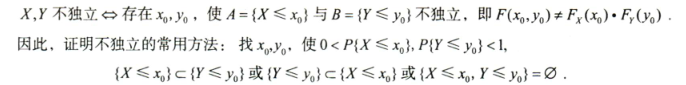

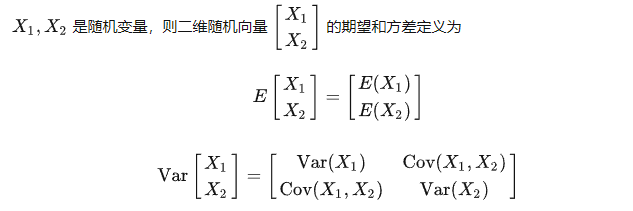

2.随机变量的独立性

之所以在一维随机变量中不讨论独立性是因为一维的随机变量只有一个不存在与谁独立,但是在二维以及多维随机变量中需要研究该问题,但是也非常简单,前面[事件的独立性](# 3.事件的独立性)中介绍了两个事件相互独立需要满足的条件,因为随机变量是事件的量化表示,所以随机变量的独立性定义与之类似。

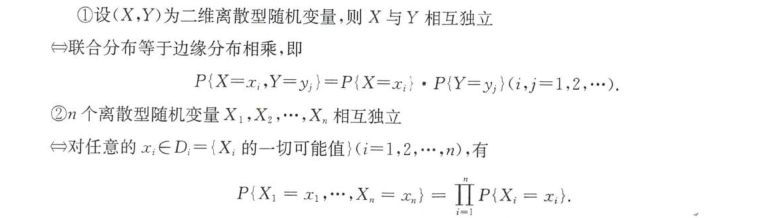

定义1:

定义2:

- 因为相互独立的定义中要求任意x,y都成立,因此利用定义正向穷举法证明随机变量独立是不可行的,但是可以利用定义找出存在一对x,y使得等式不成立进而证明不独立

2.1 离散型判独立

对于离散型随机变量,其相互独立的充要条件为

- 推论:若(X,Y)的联合分布律表格中存在p

i,j=0,则X,Y必定不独立

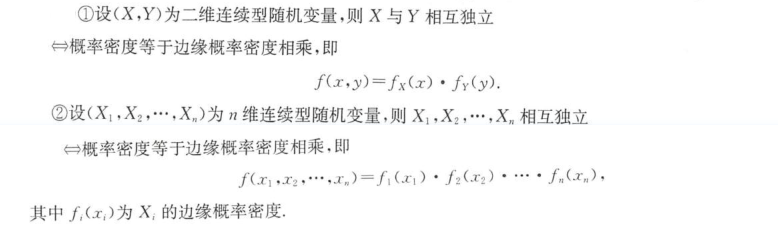

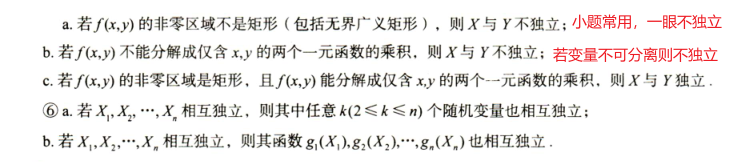

2.2 连续型判独立

对于连续型随机变量,其相互独立的充要条件为

2.3 重要性质

判独立时没有思路可以考虑使用以下口诀(非严格证明,大体不能用)

若多维随机变量相互独立,则具有如下性质

“设(X,Y)是二维随机变量,若X与Y相互独立,则条件分布等于边缘分布”

这条性质的逆用也非常实用,拿连续型随机变量举例,若X和Y相互独立,则联合概率密度f(x,y)等于边缘密度的乘积fX(x)·fY(y)

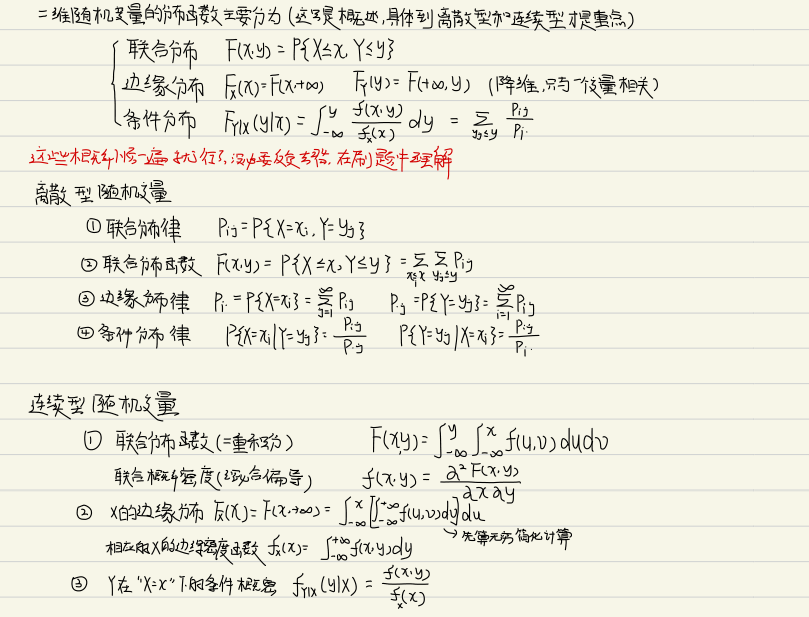

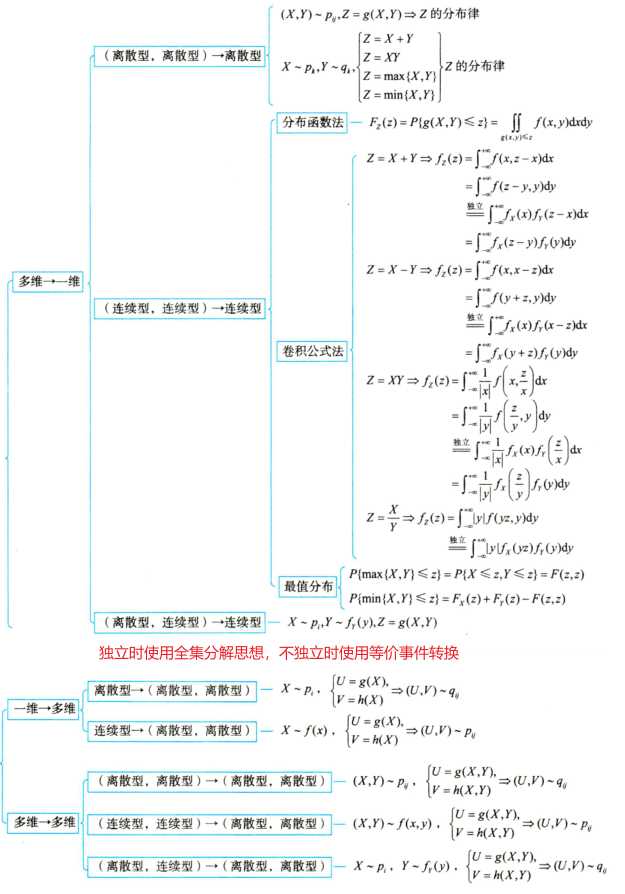

3.多维随机变量函数的分布

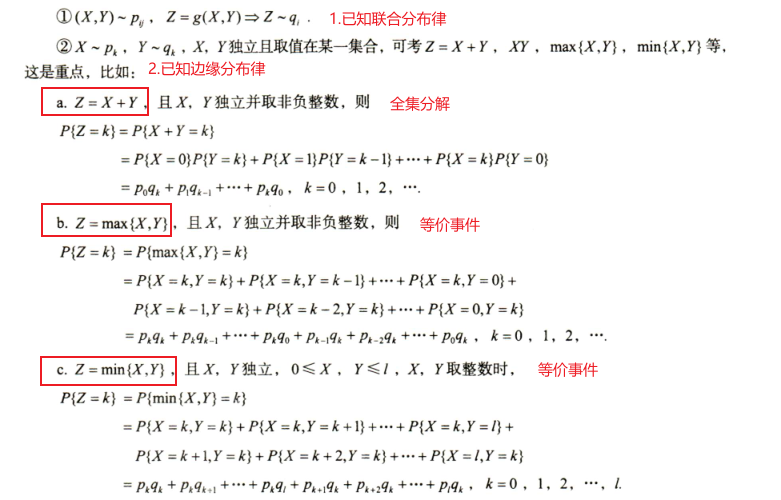

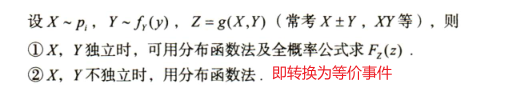

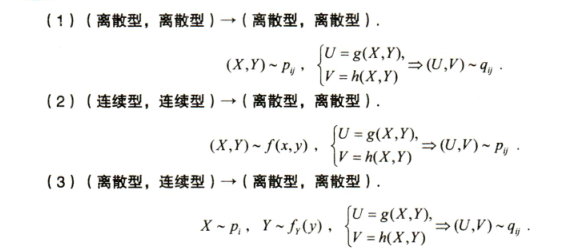

已知X,Y为随机变量,g(x,y)是二元函数,那么以随机变量X,Y作为自变量的函数U=g(X,Y)也是随机变量,被称为随机变量X,Y的函数。这部分知识体系如下

“分布函数法”好理解而且万能(但是分情况讨论很耗费时间),“卷积公式法”针对某些特定题型可以较快解决,建议在熟练掌握分布函数法的基础上再尝试使用卷积公式法;

“全集分解思想”适用于已知变量相互独立时,将事件对离散型的一切可能值进行全集分解,然后利用全概率公式求解;

“等价事件”是一种更加万能的方式,在独立条件下可以推出“全集分解”(条件分布中的条件可以甩掉)

3.1 多维->一维*

3.1.1 (离散,离散)->离散

主要有两种考题,已知联合分布律求Z的分布律(较简单)或已知边缘分布律求Z的分布律(较难)

3.1.2 (连续,连续)->连续

这部分考察已知联合概率密度,求解二维随机变量函数的分布,主要有分布函数法和卷积公式法

- 关于卷积公式法,是通过分布函数法恒等变形得到(此处不做推导),将

(1)卷积公式法

使用卷积公式法解题有依照如下严格步骤:

- 写出被积函数/概率密度函数f(x,y)以及对应法则Z=g(X,Y)

- 卷积公式三部曲

- 换概率密度函数中的字母(“积谁不换谁,换完求偏导,偏导带绝对值”),换正概密区间的字母(取值范围)

- 换区域(正概密区域图像改变)

- 计算z的边缘密度,借助口诀“求谁不积谁,不积先定限,限内画条线,先交为下限,后交为上限”

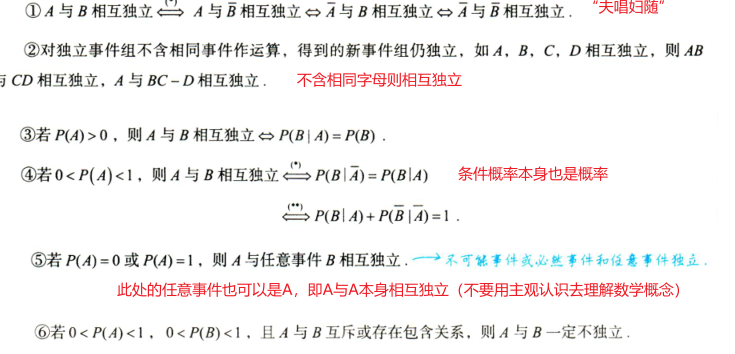

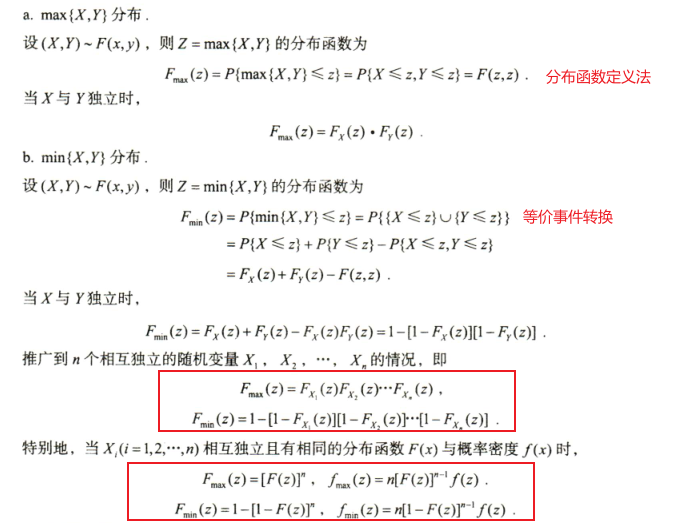

(2)最值函数的分布

- max函数和min函数并不是用卷积公式求解,这点需要注意;

3.1.3 (离散,连续)->连续

因为这种混合型的不存在联合分布故无法使用公式,只能基于分布函数的定义求解

3.2 一维->多维

3.3 多维->多维

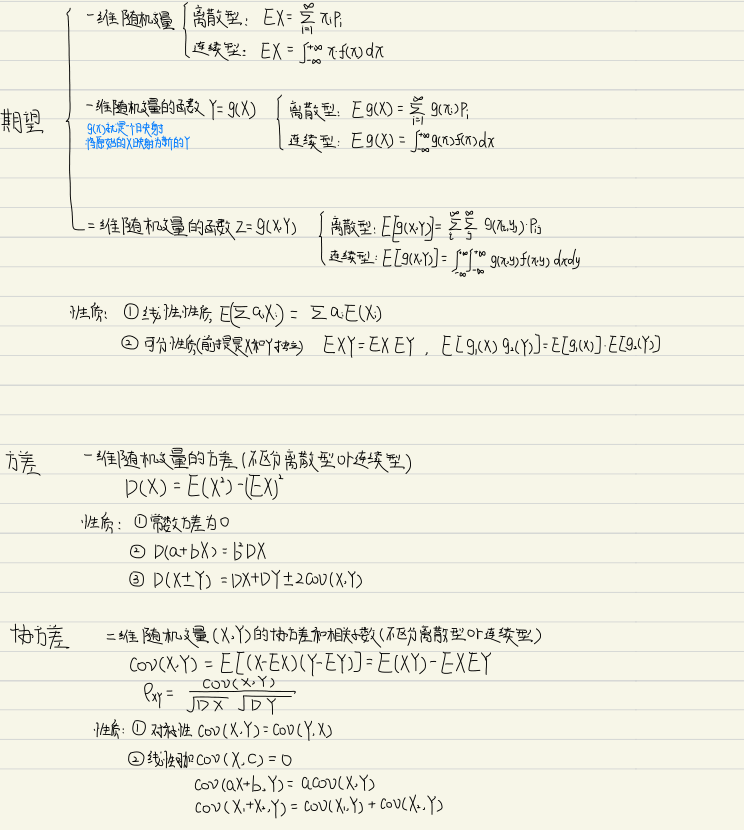

第四讲 随机变量的数字特征

在大多数时候时候并不会直接将整个随机变量的分布告知,此时若需要研究随机变量,需要寻找其数字特征。如下是第四讲的核心知识框架

1.一维随机变量的数字特征

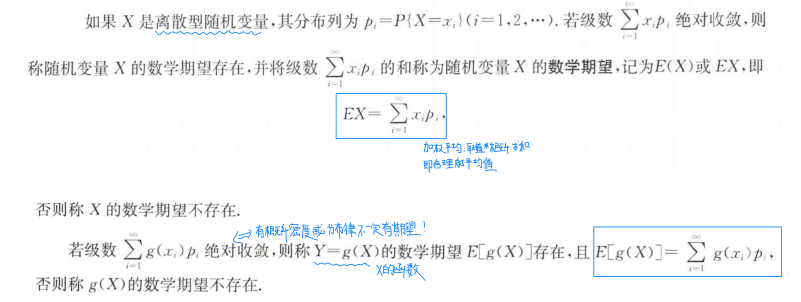

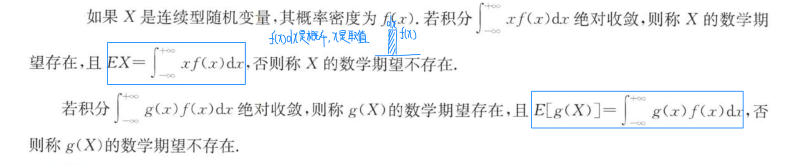

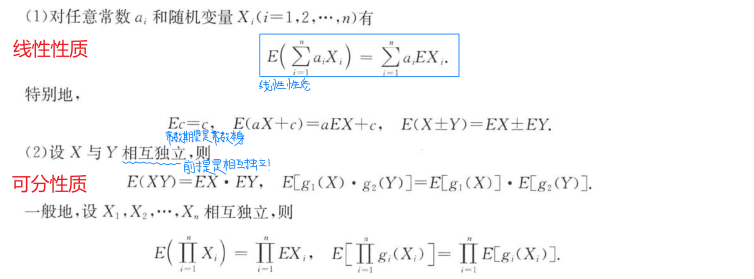

1.1 数学期望

1.1.1 数学期望的定义

离散型随机变量及其函数的数学期望定义:

连续型随机变量及其函数的数学期望定义:

- 通俗定义:数学期望就是随机变量的取值与取值概率乘积的和,诸如g(X)、g(X,Y)等的期望计算公式的基本思想都是如此;

- 根据上述定义可知,一维随机变量有概率密度或分布律不一定表示其一定有期望;

- 连续型随机变量的函数的数学期望的公式非常好理解,把x那一点的取值用g(x)替代即可,其取值对应的概率密度f(x)不变;

数学期望又被称为概率平均值,常常简称为期望或均值,主要刻画了随机变量的一切可能值的集中位置;

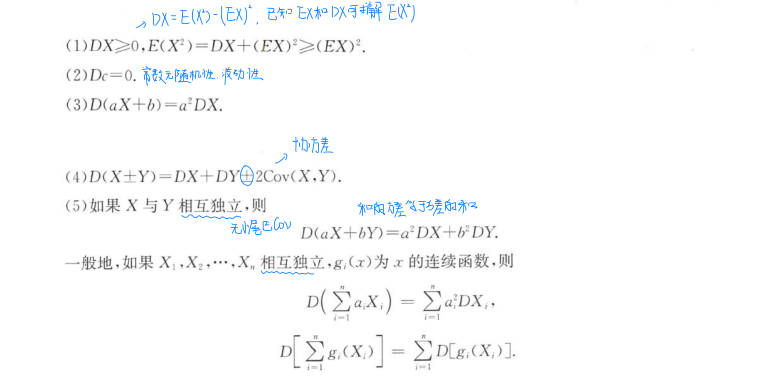

1.1.2 数学期望的性质

对于数学期望,主要有以下性质:

- 随机变量的数学期望是一个常数,常数的期望是其本身;

- 随机变量分解思想

- 根据数学期望的线性性质,当a

i=1时,即在任何条件下,若X=X1+X2+…+Xn则有EX=EX1+EX2+…+EXn; - 在任何条件下,若X=X

1+X2+…+Xn则有DX=DX1+DX2+…+DXn+2ΣCov(Xi,Xj),在独立的条件下协方差可消去; - 这种分解思想在面对一些随机变量本身的分析很麻烦的情况下,不直接利用随机变量的概率分布,仅利用数学期望和方差的性质就可求解。一般的做法是将原随机变量X分解为伯努利随机变量X

i,利用Xi的期望和方差来求解X的期望和方差(这个的技术性太高了,目前也只知道这么做,后续遇到了新题型再补充)

- 根据数学期望的线性性质,当a

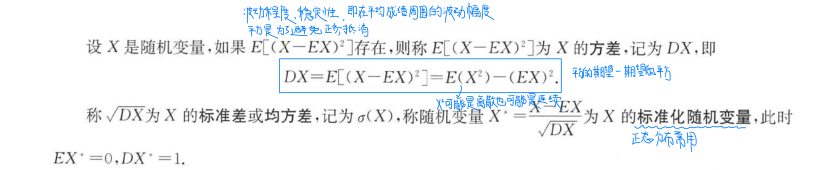

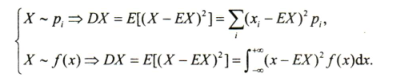

1.2 方差&标准差

1.2.1 方差的定义

随机变量方差的定义:

- 通俗定义:随机变量X的方差DX就是(X-EX)^2^的期望,因此有以下公式成立(不常用,一般使用的是上述定义中的公式计算)

1.2.2 方差的性质

随机变量的方差通常有如下性质:

补充一个重要等式,常用于快速计算某些题型

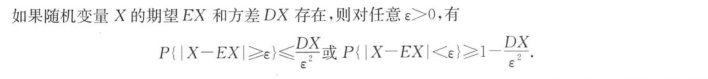

1.3 切比雪夫不等式

切比雪夫不等式主要描述了这样一件事:随机变量X与其数学期望EX的差值不会很大,即该差值>=ε的概率会很小

定义:

- 由切比雪夫不等式知,当DX愈小时,概率P{|X-EX|<ξ}愈大(即X和EX比较接近,随机变量的波动性较小),这表明方差是刻画随机变量与其期望值偏离程度的量,是描述随机变量X“分散程度”特征的指标;

- 使用切比雪夫不等式估算随机变量在某取值的范围内的概率,比如估计概率P{|X-Y|>=6},则令Z=X-Y(绝对值内部的表达式),取ξ=6即可证明;

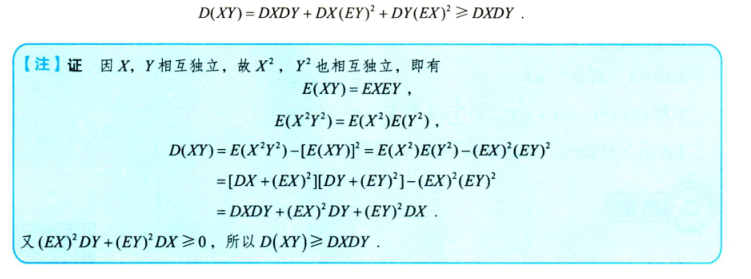

2.二维随机变量的数字特征

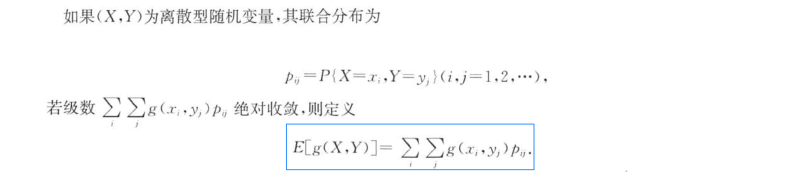

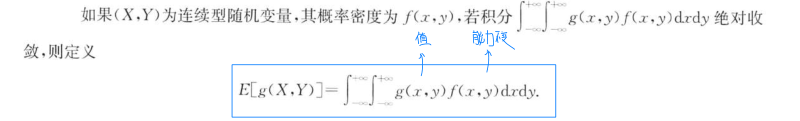

2.1 数学期望

设X,Y为随机变量,g(X,Y)为X,Y的函数,其中g是连续函数

二维离散型随机变量函数的数学期望:

二维连续型随机变量函数的数学期望:

Q:为什么只有二维随机变量的函数的期望而没有二维随机变量的期望?

A:其实关于二维随机变量的期望和方差是有定义的,但是一般我们不会考察,下面给出二维随机变量的期望和方差定义(因为两个变量之间的关系不确定因此使用空间矩阵表示)

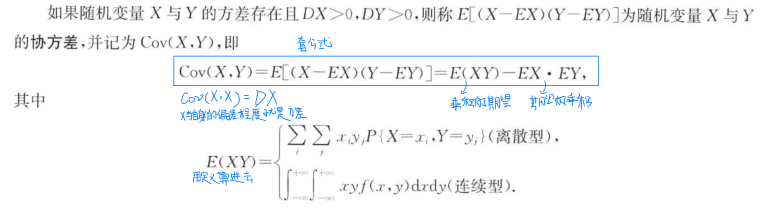

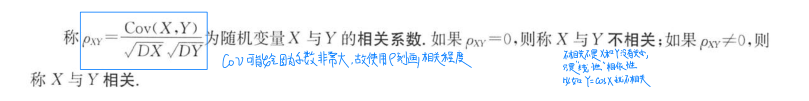

2.2 协方差与相关系数

2.2.1 定义

协方差的定义:

- 协方差的计算式除了用期望表示以外,可以用方差表示Cov(X,Y)=1/2[D(X+Y)-DX-DY]

相关系数的定义:

- 协方差只表示线性相关的方向,取值范围为(-∞,+∞)

- 协方差为正值,说明一个变量变大另一个变量也变大;取负值说明一个变量变大另一个变量变小,取0说明两个变量没有相关关系

- 相关系数不仅表示线性相关的方向,还表示线性相关的程度,取值范围为[-1,+1]

- 相关系数为正值,说明一个变量变大另一个变量也变大;取负值说明一个变量变大另一个变量变小,取0说明两个变量没有相关关系。同时,相关系数的绝对值越接近1,线性关系越显著

- 相关系数是标准化后的特殊协方差,相关系数比协方差多阐述了线性相关的程度。相关系数等于0表示X与Y之间不存在线性关系,称为不相关,但X和Y之间可能存在其它非线性关系;

2.2.2 性质

协方差和相关系数主要有如下性质:

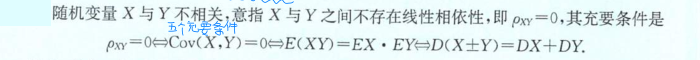

3.独立性与相关性

3.1 独立性

通过分布来判断独立性(独立就是指没有任何关系)

3.2 相关性

通过数字特征来判断相关性(最终落实到E(XY)=EXEY上)

3.3 重要结论

相关性和独立性有以下几个重要结论:

如果X与Y相关,则X,Y不独立,反之不一定;

如果X与Y独立,则X,Y不相关,反之不一定;

如果(X,Y)服从二维正态分布,则X,Y相互独立与X,Y不相关互为充要条件

如果(X,Y)服从两点分布,则X,Y相互独立与X,Y不相关互为充要条件

一般解题,要求讨论随机变量X和Y之间的相关性和独立性时,先计算协方差判断相关性,再通过分布判断独立性

第五讲 大数定律与中心极限定理

第五讲作为概率论知识点中的最后一讲,其主要意义在于将概率论中的知识点进行汇总并适当与数理统计联系作为章节过渡(承上启下)。

大数定律用最简单的话来说就是“测试的次数越多得到的实验结论越准确”;中心极限定理的“中心”指的是这个系列定理很重要,用最简单的话来说就是“任何大量相互独立的随机变量的和的极限分布是正态分布”。

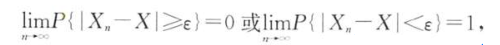

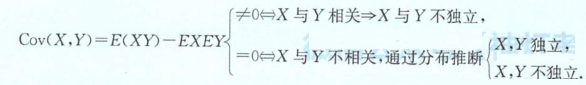

1.依概率收敛

设随机变量X与随机变量序列{X

n}(其中n=1,2,3…),如果对任意的ε>0有

则称随机变量序列{X

n}依概率收敛于随机变量X,记作

定义中的变量含义:

X是随机变量,代表了所有事件的集合(即事件可能发生的所有结果);

X

n表示试验n次事件发生的集合;依概率收敛说的就是,当n趋于无穷也就是当试验次数足够大的时候,事件发生的集合X

n几乎和事件可能发生的结果的集合X一致;公式中的|X

n-X|<ε表示的是一个事件,其概率衡量了两个集合的相似程度,此处的随机变量X也可以用常数a来替代;

若题干要求证明Xn依概率收敛到a,主要步骤如下:

- 构造并计算表达式P{|X

n-a|<ξ} - 计算极限limP{|X

n-a|<ξ}

Q:此处的依概率收敛与高数中极限收敛有什么关系?

A:

高数中的极限收敛之所以不像概率论中的依概率收敛带概率,本质上是因为极限收敛中的通项Xn是确定的,而概率收敛中的Xn表示随机事件,因此需要借助概率对其进行度量

2.大数定律

大数定律告诉我们可以用频率近似代替概率,能用样本均值近似代替总体均值(数学期望)。大数定理将属于数理统计的样本均值和属于概率论的数学期望(总体均值)联系在一起,为用统计方法来估计期望提供了理论依据。(大数定律的考点主要在其使用条件,而n->∞作为默认使用条件也应当注意)

| 大数定律 | 分布 | 期望 | 方差 | 用途 |

|---|---|---|---|---|

| 伯努利 | 二项分布 | 相同 | 相同 | 估算概率 |

| 辛钦 | 独立同分布 | 相同 | 相同 | 估算期望 |

| 切比雪夫 | 独立 | 存在 | 存在且有上界 | 估算期望 |

可以认为伯努利大数定律与其他两个不属于同一体系

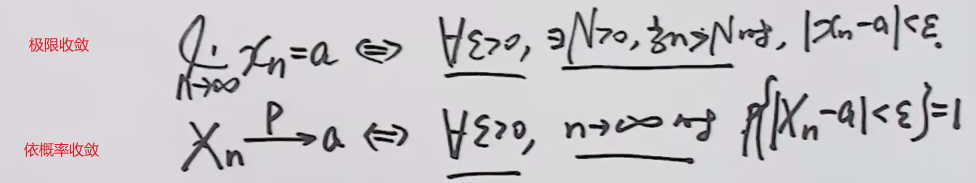

2.1 切比雪夫大数定律

速记:样本均值依概率收敛到期望的均值(等价于均值的期望,也就是数学期望),是所有大数定理的本质

成立条件:

- 相互独立

- 方差存在且一致有上界(有公共上界)

- 上述式子中的X

i可以广义化,常考的是左右两边同时广义化为Xi的函数g(Xi);- 相比于辛钦大数定律,切比雪夫并没有要求随机变量是同分布的,因此更具一般性;

- 切比雪夫大数定律的使用条件“为{X

n}相互独立和DXi存在且一致有上界C”,出题点常在计算DXi得出其无上界,进而不服从切比雪夫大数定律;

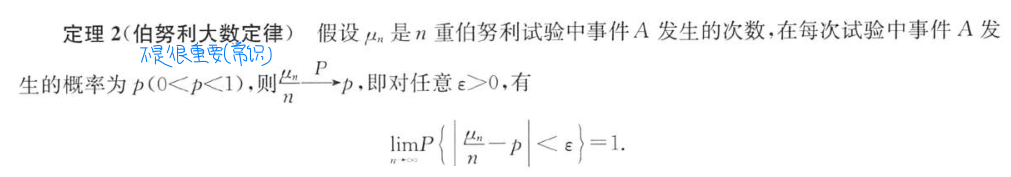

2.2 伯努利大数定律

速记:频率依概率收敛到概率,由切比雪夫不等式推导

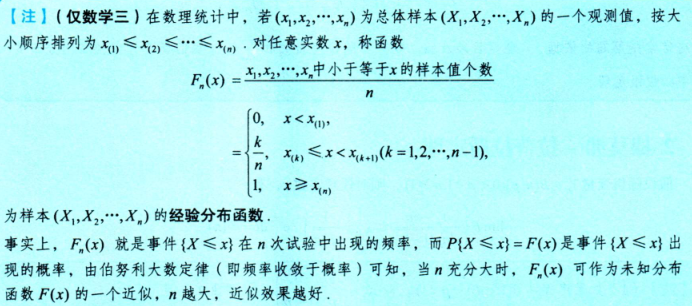

由伯努利大数定律可以拓展得到经验分布函数,即使用经验分布函数来近似分布函数

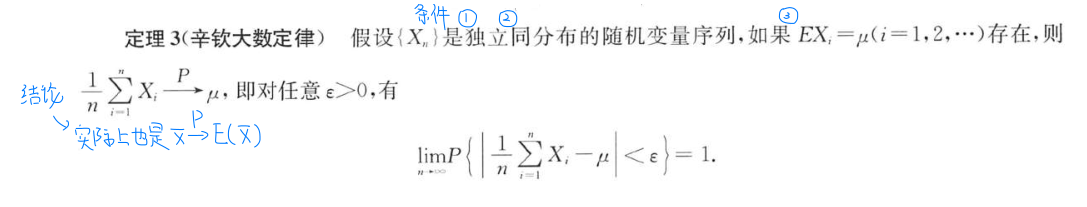

2.3 辛钦大数定律*

速记:样本均值依概率收敛到数学期望,是伯努利大数定理的推广

成立条件:

- 相互独立

- 同分布(若X

i为来自总体X的简单随机样本,则Xi独立同分布于X) - 期望存在

- 因为{X

n}是独立同分布的随机变量序列,可以推出Xi的期望都相同即E(Xi)=u;- 当X

i是服从0-1分布的随机变量时,辛钦大数定律就是伯努利大数定律(不常考,知道就行)- 辛钦大数定律的使用条件为“{X

n}独立同分布且EXi存在”,出题点常在“EXi存在”,比如“{Xn}服从同一离散型分布”或“{Xn}服从同一连续型分布”都不能保证数学期望一定存在,因此不服从辛钦大数定律;

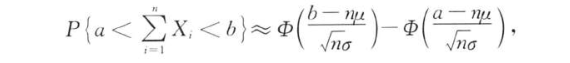

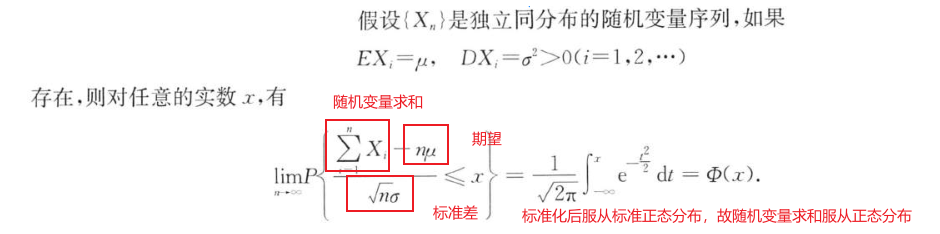

3.中心极限定理

中心极限定理用一句话概括:“在一定条件下,大量独立同分布的随机变量的和的极限分布是正态分布(任何分布求和近似正态分布)”。

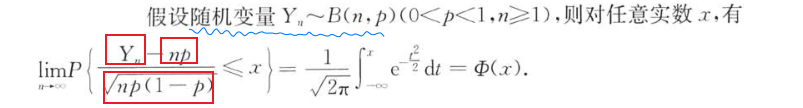

3.1 列维-林德伯格定理*

上述式子中,带极限则等号成立,不带极限则约等号

- 定理的三个条件“独立、同分布、期望和方差存在”缺一不可(注意具有相同的期望和方差并不一定同分布);

- 该定理说明了这样一件事,当独立同分布的随机变量序列{X

n}满足EXi=u,DXi=σ^2^时,有求ΣX~i~~(nu,nσ^2^)- 该定理有另一种变式,即

3.2 棣莫弗-拉普拉斯定理

- 拉普拉斯定理是由林德伯格定理推导得来的,因为二项分布可以认为是由n个两点分布求和得到,即二项分布在n很大时近似正态分布

第六讲 数理统计

1.总体与样本

前面已经讲过数理统计和概率论的区别,数理统计是一门基于现实的,根据观察到的结果来估计未知概率规律的学科。

下面介绍几个数理统计中最基础的概念:

- 总体:研究的对象的全体称为总体(工厂生产的所有灯泡),组成总体的每一个元素称为个体(每一个灯泡)。数理统计中的总体等同于概率论中的随机变量X的概念,故总体的分布实际就是指随机变量X的分布;

- 样本&样本值:n个独立同分布于总体的随机变量X

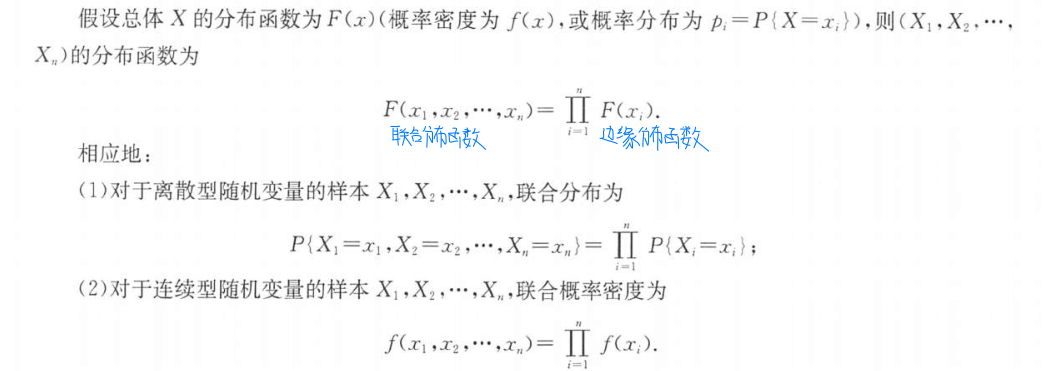

1,X2…Xn组成的整体(X1,X2…Xn)被称为来自总体X且容量为n的一个简单随机样本,简称样本(一组随机变量,n个被抽取的灯泡)。一次抽样结果的n个具体数值(x1,x2…xn)称为对应样本X1、X2…Xn的一个观测值(一组样本值); - 样本的分布:因为容量为n的样本(X

1,X2…Xn)中的n个随机变量独立同分布,因此有如定理成立

数理统计这门学科就是利用抽取的样本(X

1,X2…Xn)对总体X的分布函数、数学期望、方差等做出估计;

2.统计量及其分布

2.1 统计量的定义

统计量的定义:设X

1,X2…Xn是来自总体X的一个样本,g(x1,x2…xn)是n元函数,如果g中不包含任何未知参数,则称g(X1,X2…Xn)是样本X1,X2…Xn的一个统计量。若x1,x2…xn为样本值(观测值),则称g(x1,x2…xn)是g(X1,X2…Xn)的观测值;

数理统计中往往不会直接使用样本本身,通常针对不同问题来构造不同的样本的函数,该函数就被称为统计量;

- 统计量能够提供有关总体参数的信息,并且在不同问题和场景下可以构造适当的统计量;

- 使用统计量而不直接使用样本本身有助于简化数据、减少随机性的影响、提供总体参数的估计和进行假设检验;

- 构造适当的统计量是为了更好地回答我们感兴趣的问题,并从样本数据中提取有用的信息;

作为随机变量的函数,统计量也是一个随机变量(关于多维随机变量的函数,可参考[二维随机变量函数的分布](# 5.多维随机变量函数的分布)),因此统计量也存在分布,也就是之后会介绍的三大分布;

Q:总体、样本以及统计量之间有什么联系?

A:这三者都是随机变量,抽象总体为理想概率论模型,具体样本为现实统计学模型,统计量是针对具体样本的处理手段

2.2 常用统计量

样本数字特征和顺序统计量都是常用的统计量(除了常见的统计量,根据具体问题和分析需求,还可以构造其他统计量来描述和分析数据)

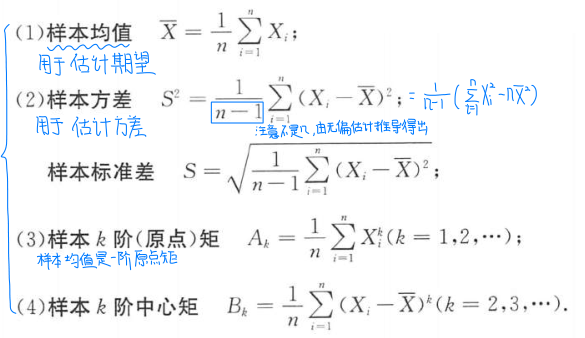

2.2.1 样本数字特征

注意,总体X的数字特征如数学期望(总体均值)、方差和标准差、矩等都是概率论中的理想概念,这里介绍的样本数字特征是数理统计中的真实统计概念(因此在说均值或者方差的时候不加“样本”前缀一般都默认是总体的数字特征)。

设X1,X2…Xn是来自总体X的简单随机样本,则相应的样本数字特征定义如下

2.2.2 顺序统计量

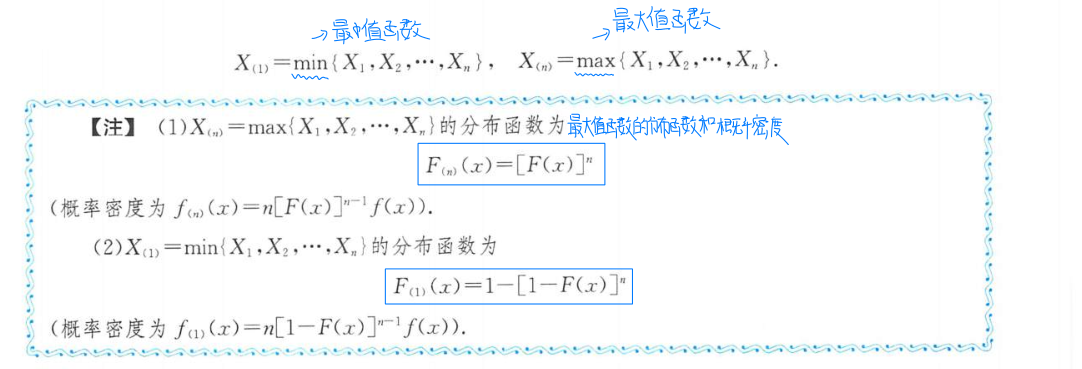

将样本X1,X2…Xn的n个观测值按照取值从小到大的顺序排列x(1)<=x(2)<=…<=x(n),称随机变量X(k)为第k顺序统计量,其中X(1)是最小顺序统计量,X(n)是最大顺序统计量

最大值函数和最小值函数的一个重要考点是作为随机变量的函数的时候的分布,对应结论如下(常用于综合性大题)

2.2.3 常用统计量的数字特征

对上面的结论做进一步的解释。首先介绍无偏估计的概念

$$

若E(θ’)=θ,则称θ’是θ的无偏估计

$$

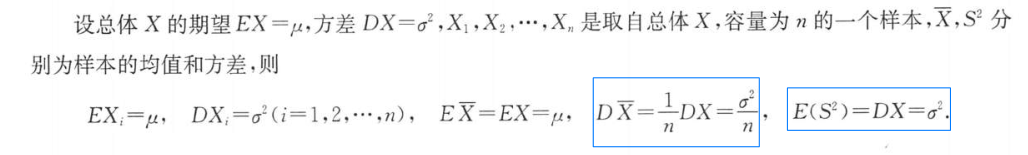

已知总体X的期望为EX,方差为DX。样本的均值和方差分别是X^——^和S^2^。我们也可以利用无偏估计的概念联系总体和样本之间的数字特征

2.3 三大分布

三大分布作为之后参数估计和假设检验的铺垫,均源自正态分布(这些分布都是概率论中的概念)。三大分布是数理统计中最常用的抽样分布(即统计量的分布,换句话说,统计量经常都服从这三大分布之一),这三大分布的概率密度无需记忆,只需要知道相应统计量的典型模式以及对应分布曲线的示意图和分位数即可。

这三大分布都是统计量的分布,此处的统计量并不是指前面介绍的常见统计量,而是一些具有特殊分布的统计量。

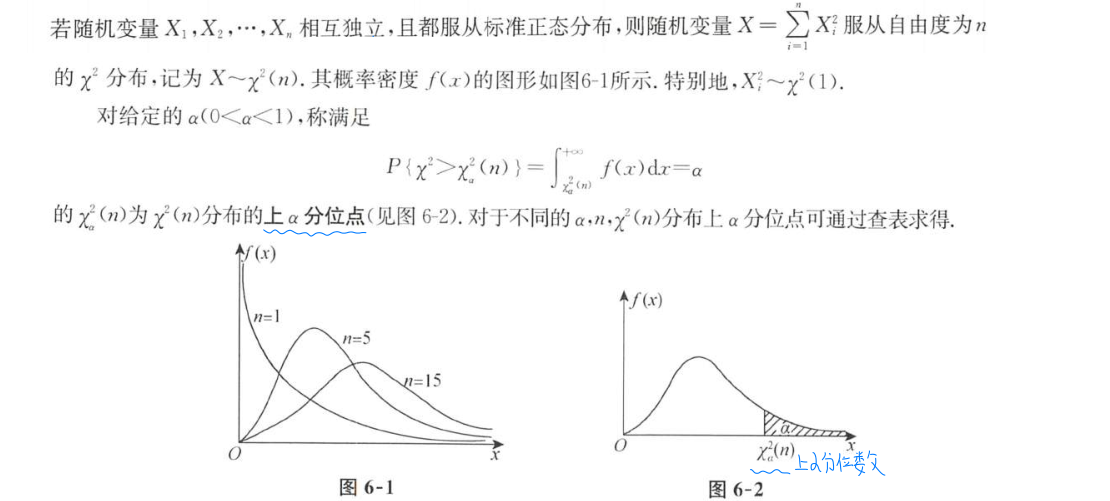

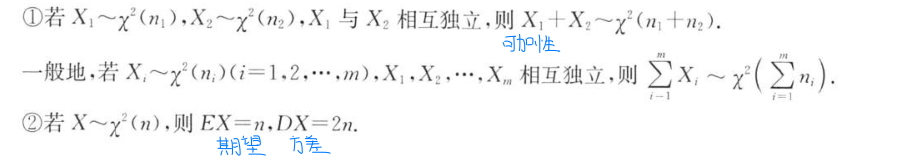

2.3.1 卡方分布

(1)典型模式

- 为了记忆,我们可以将服从卡方分布的统计量X称为卡方统计量,后续t统计量、F统计量同理;

- 自由度是指和式中的独立变量的个数;

- 某分布的上α分位点(上侧α分位数)为μ

α指的是:点μα的右侧,概率密度曲线下方与x轴围成区域的面积为α – 注意上分位点uα是x轴上的一个点,即x=uα;

(2)性质

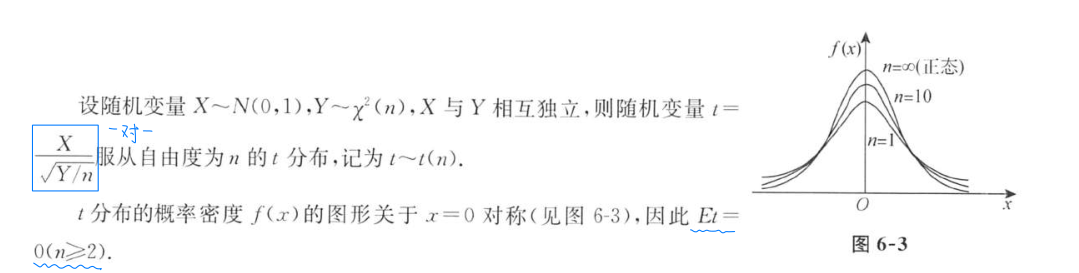

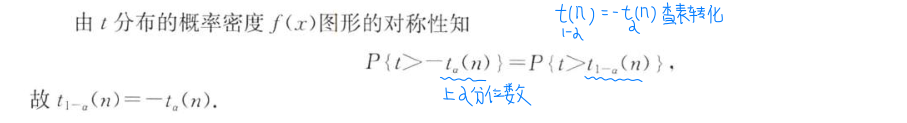

2.3.2 t分布

(1)典型模式

(2)性质

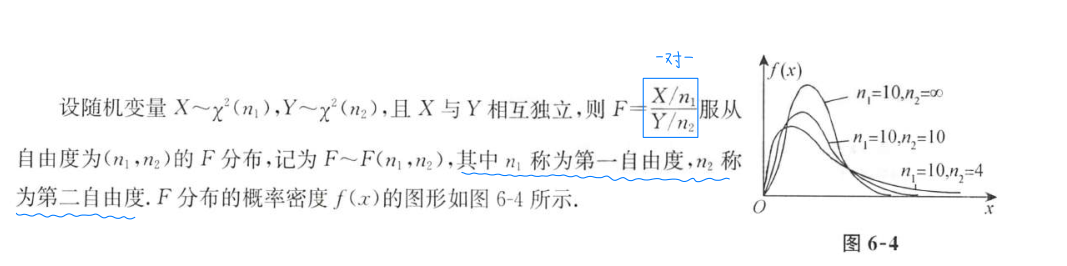

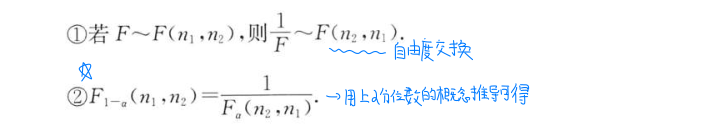

2.3.3 F分布

(1)典型模式

(2)性质

额外的,t分布与F分布之间的相互转换

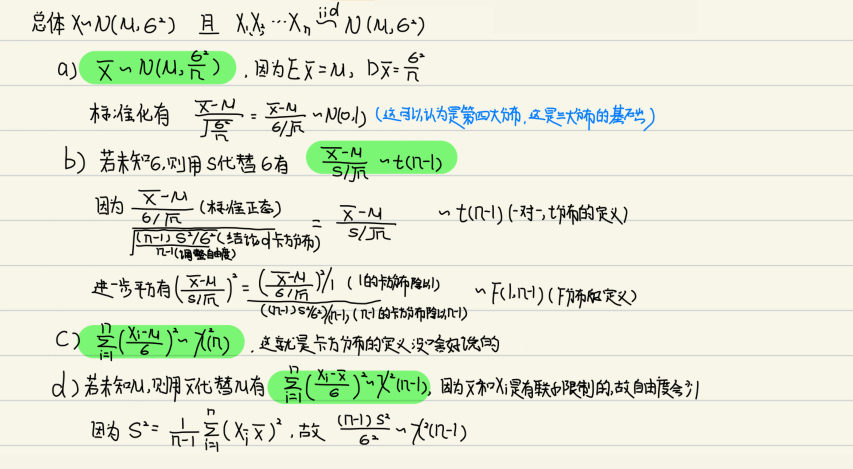

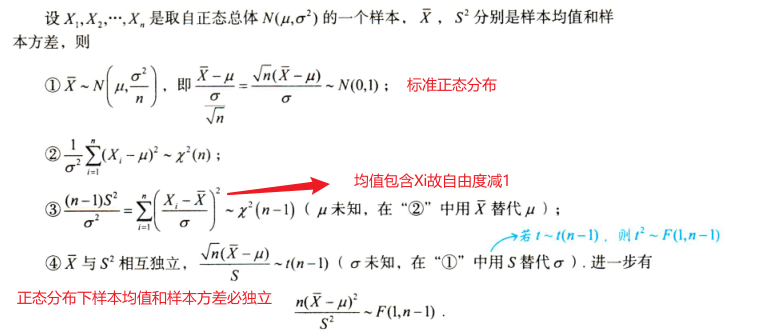

2.3.4 正态总体下的结论*

- 上述四个结论实际上是三大分布的应用,也是后面参数估计和假设检验的理论依据,直接看结论可能存在一定难度,下面给出推导过程

3.点估计和评价标准

参考链接:统计学基础–点估计和区间估计 - 知乎 (zhihu.com),举个简单的例子点估计就是估计全校男生身高为1.75m,区间估计就是估计全校男生身高在1.70~1.80m之间;

数理统计就是一门根据样本数据情况推断总体数据情况的学科,主要分为以下三种类型:

- 样本均值–>总体均值

- 样本方差–>总体方差

- 样本比例–>总体比例

将根据样本统计量的数值对总体参数进行估计的过程称为参数估计,根据参数估计的性质的不同,将其分为如下两种类型:

点估计:利用样本数据,对未知的参数进行估计所得到的一个具体的数据;

- 常用样本均值估计总体均值,或用样本标准差估计总体标准差;

- 点估计不能提供估计参数的估计误差大小;

区间估计:通过样本数据,估计未知参数,在可信度下的最可能的存在区间中得到的,结果是一个区间;

- 常用样本比例估计总体比例;

- 区间估计就是在推断总体参数时,还要根据统计量的抽样分布特征,估计出总体参数的一个区间,而不是一个数值,并同时给出总体参数落在这一区间的可能性大小,概率的保证;

点估计使用样本统计量来估计总体参数,因为样本统计量为数轴上某一点值,估计的结果也以一个点的数值表示,所以称为点估计。

3.1 概念

设总体X的分布函数为F(x,θ),其中θ是一个未知参数。X1,X2…Xn是取自总体X的一个样本,由样本构造的一个统计量θ^(X1,X2…Xn)作为参数θ的估计量,如果x1,x2…xn是样本的一个观测值,将其代入估计量θ^中称这个值为未知参数θ的估计值。

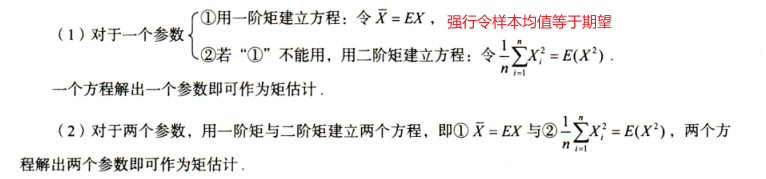

3.1.1 矩估计法

矩估计法的特点是不需要知道总体X的分布,但这就导致不能充分利用已知的信息(比如已知总体分布是正态分布但是因为使用的是矩估计,所以这个信息不会被使用),矩估计量不具备唯一性;

矩估计的基本思想就是利用样本均值去逼近总体均值,用样本方差估计总体方差(分一个未知参数和两个未知参数的情况)

- 因为点估计都是“估计”,故最终得到的结果不是精确值而是估计值,估计值一般带^与精确值做区分;

- 矩估计量中的样本均值大写,矩估计值中的样本均值小写;

- 矩估计中,能用一阶矩就不能用二阶矩,只有当一阶矩不能使用时(一阶矩求解出来不包含未知数即无法建立方程)才能用二阶矩;

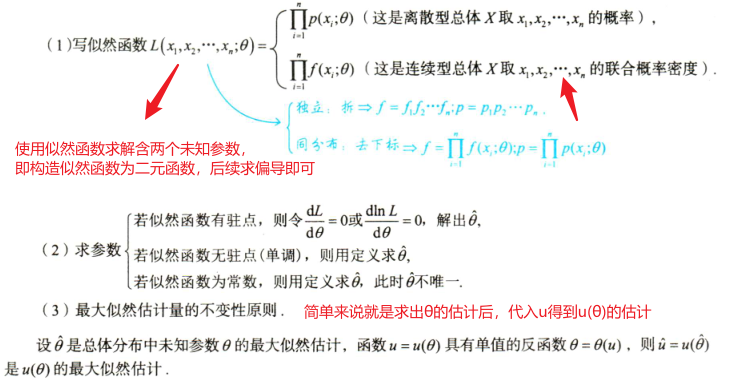

3.1.2 最大似然估计

基本思想是最大似然原理,即在未知参数θ取某个值的时候,整个样本获得观测值的概率最大的参数值θ^作为θ的估计。可以使用以下形式帮助理解

$$

θ作为一个标签取值为多少时,概率P(抽样得到的观测值;Θ)最大

$$

根据总体X是离散型还是连续型分为不同的似然函数,主要求解步骤如下

- 连乘的处理方式是先求对数再求导;

- 若似然函数无驻点,意味着似然函数单调

- 若似然函数单调增,要使得似然函数得最大值,需具体分析似然函数的等式以及参数取值范围

- 若似然函数单调减,要使得似然函数得最大值,需具体分析似然函数的等式以及参数取值范围

- 若似然函数为常数,同样类似上述分析,利用范围求解参数。此时求解出的点估计量是处于一个区间内的,表明此时的点估计量不具备唯一性;

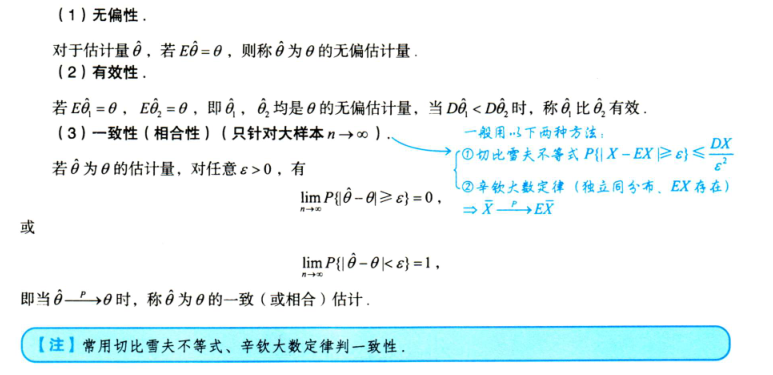

3.2 估计量的评估

4.区间估计和假设检验

4.1 区间估计

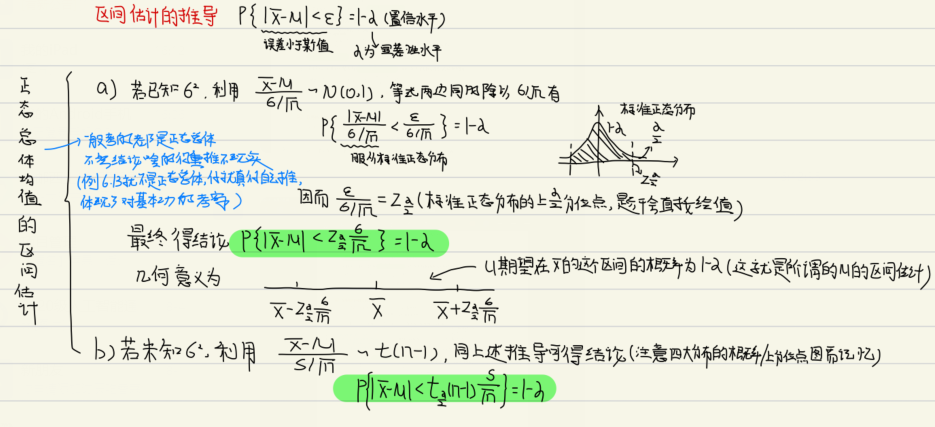

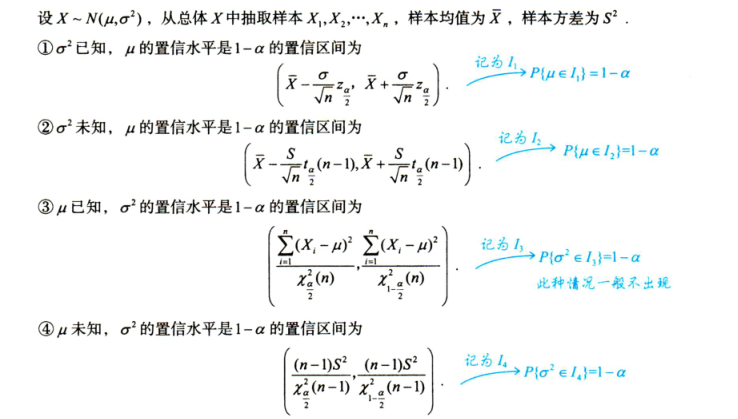

给定置信度求未知参数置信区间的问题,称为参数的区间估计问题(置信区间的长度表示估计的精度,置信区间越短表示估计的精度越高)。区间估计的推导过程如下(主要依赖前面介绍的[正态总体下的结论](# 2.3.4 正态总体下的结论* ))

下面给出正态总体均值的置信区间结论

4.2 假设检验

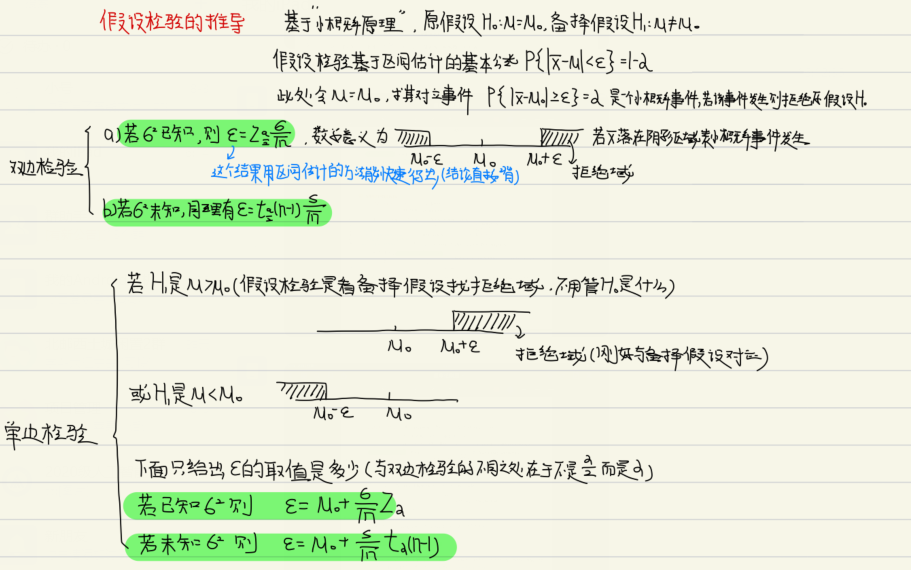

区间估计与假设检验的关系非常密切,假设检验的推导如下(即小概率事件发生则拒绝整个H0原假设)

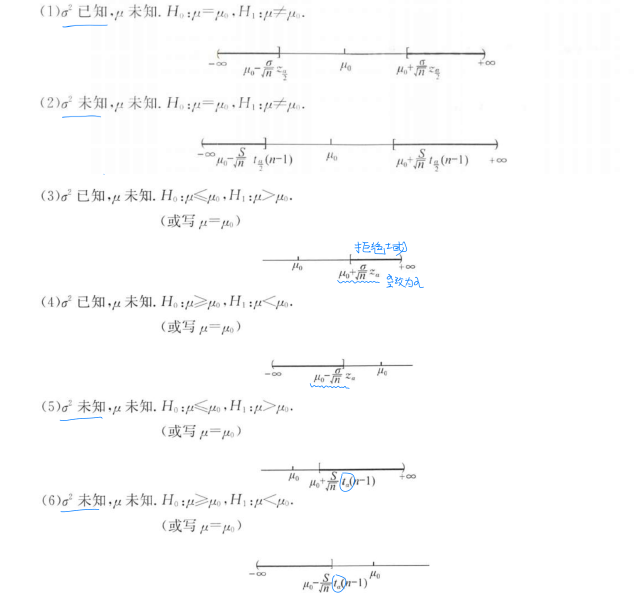

下面给出正态总体下的六大检验及其拒绝域

- 拒绝域的形式与备择假设H

1的形式一致,方便记忆

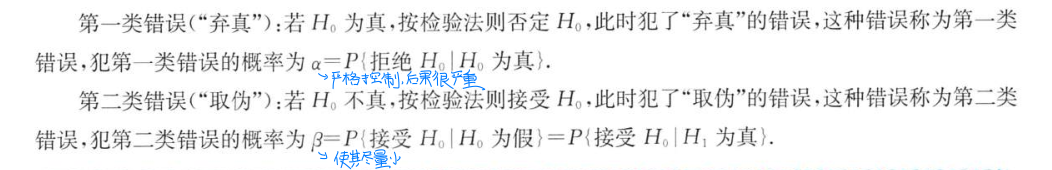

4.3 两类错误

其中犯第一类错误的概率α就是前面所说的显著性水平α(但是在具体的考题中不会利用这个性质来求α,求解α和β都是直接利用公式计算条件概率),比如P{判定无病|有病}=α,这个α一定要严格控制(有病但是不治疗后果很严重);第二类错误可以认为是P{判定有病|无病}=β,这个β尽量小即可(没有病多吃点药可能影响不大)

- 犯两类错误的概率α与β,并不满足β=1-α,在固定样本容量n的条件下,α小,β就大;β小,α就大.在实际应用中,我们总是在控制α的条件下,尽量使β小,这是因为人们常常把拒绝H

0比错误地接受H0看得更重要; - 某些考题可能会更换措辞,针对这种题型只需要记住上述基本结论和下面的等价描述

- 拒绝H

0==接受H1 - 接受H

0==拒绝H1 - H

0为真==H1为假 - H

0为假==H1为真

- 拒绝H